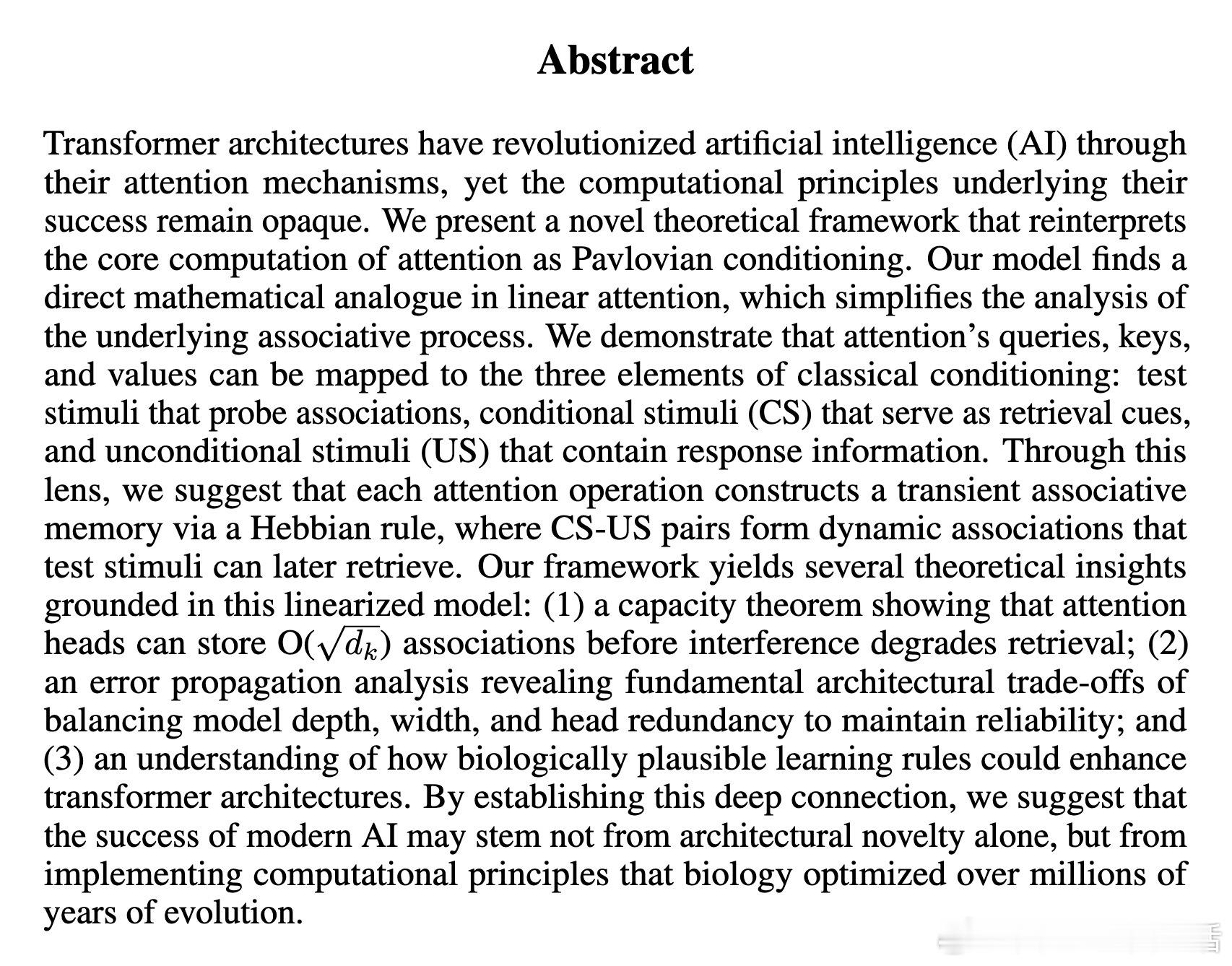

[LG]《Understanding Transformers through the Lens of Pavlovian Conditioning》M Qiao [Meta Platforms, Inc] (2025)

Transformer注意力机制的核心计算与经典的巴甫洛夫条件反射高度契合,揭示了其成功背后的本质原理:

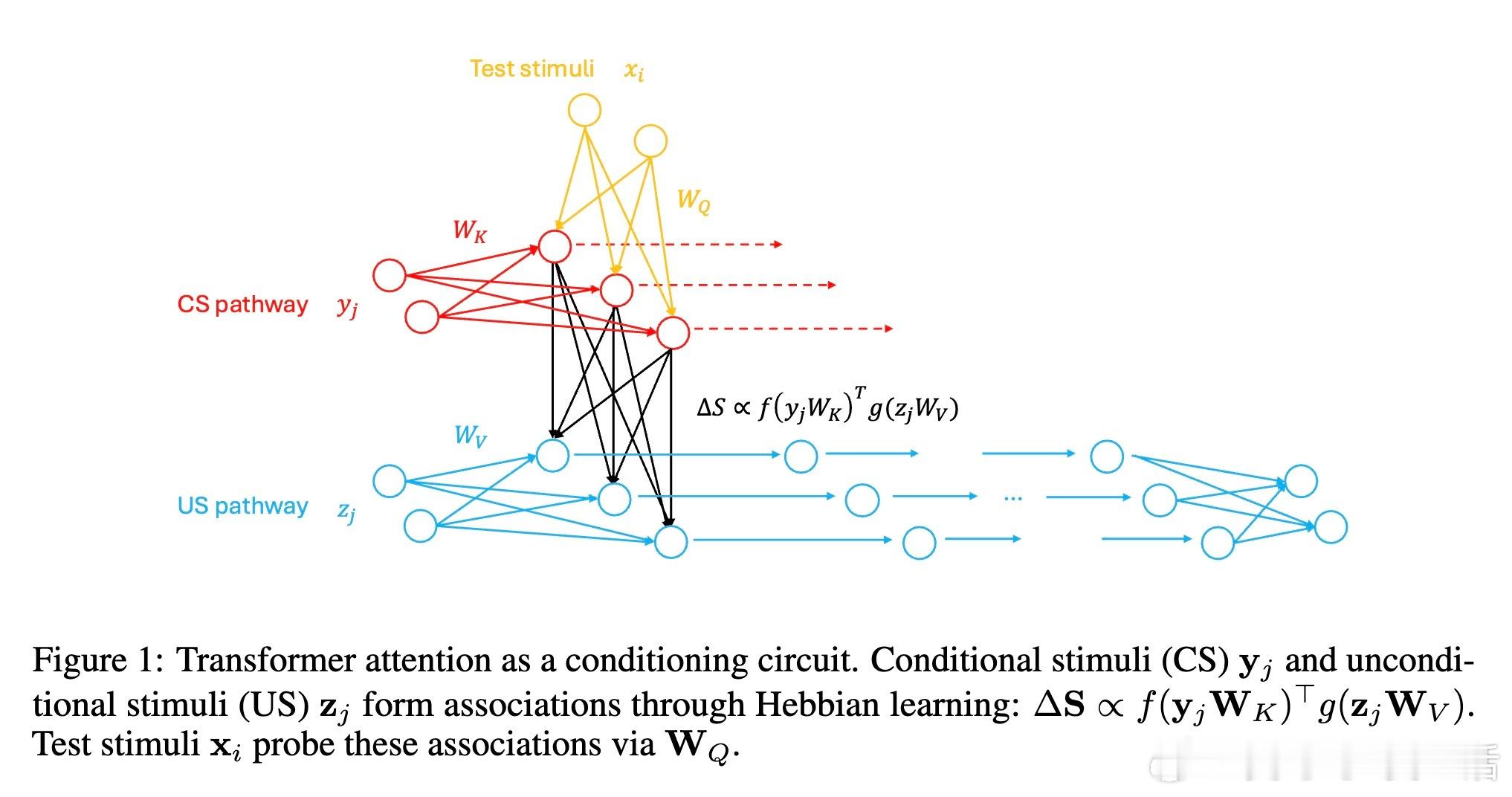

• 结构映射:Transformer中的 queries、keys、values 分别对应测试刺激(Test Stimuli)、条件刺激(CS)、无条件刺激(US),形成动态关联记忆。

• 联想记忆形成:通过Hebbian学习规则,条件刺激与无条件刺激的配对在推理时动态建立关联矩阵,支持类似生物条件反射的快速推理能力。

• 数学等价性:该条件反射框架严格对应线性注意力机制,简化了对注意力本质的分析,揭示其内在的记忆容量和干扰限制。

• 容量与干扰:关联记忆容量受键向量维度限制,可靠检索的关联数量近似为键维度的平方根,提示上下文长度增长会带来记忆干扰。

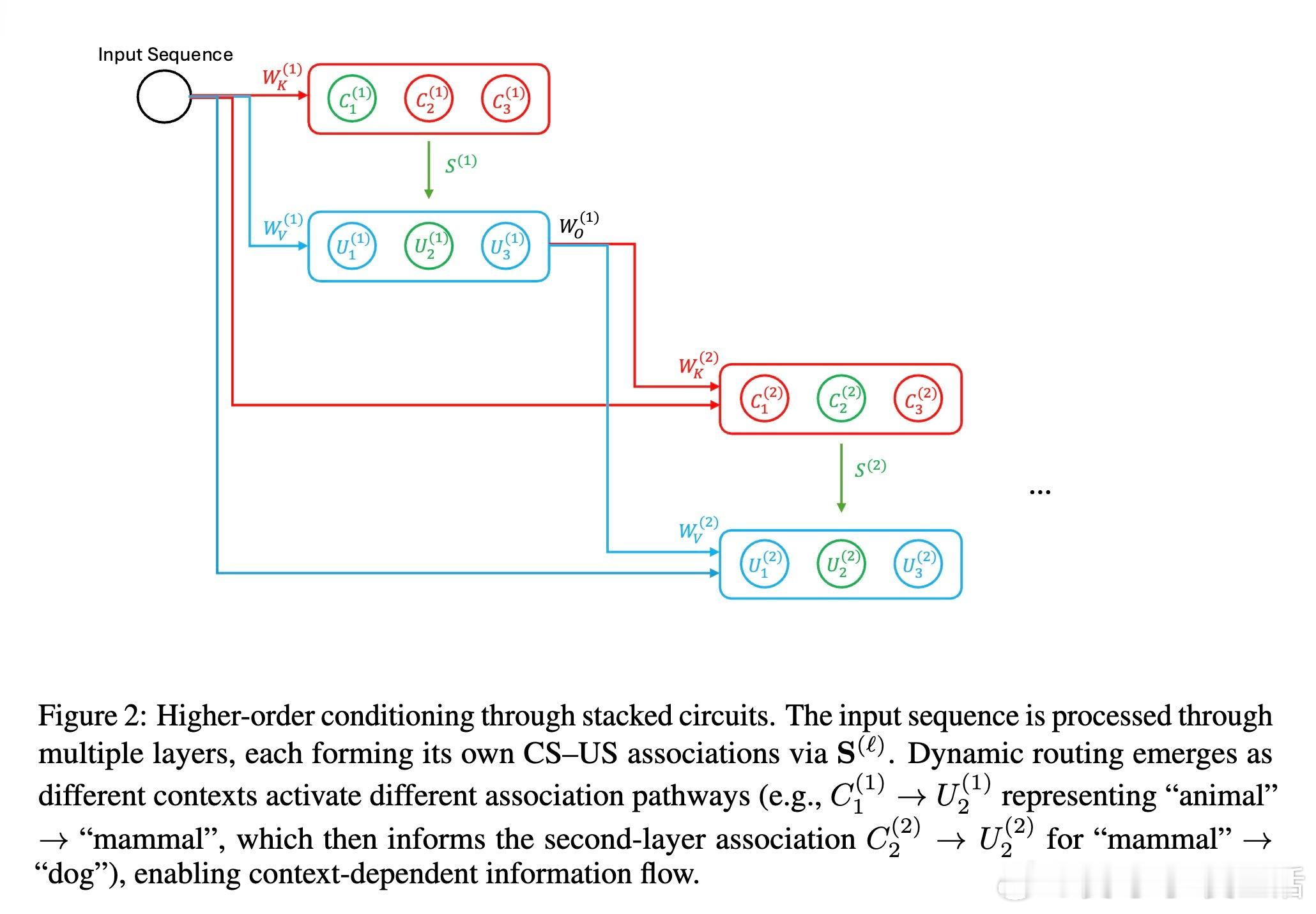

• 多层次联想:深层Transformer通过堆叠条件反射电路实现高阶条件作用,支持复杂的组合推理和动态路径路由,体现上下文依赖的灵活计算。

• 错误传播与架构权衡:多层叠加导致错误累积,模型须在深度、宽度、头数间权衡以保证稳定性,多头机制提供关键冗余以增强鲁棒性。

• Hebbian规则变体:Delta规则、Oja规则、BCM规则等生物启发机制可解决错误校正、权重稳定和适应性注意力的挑战,为Transformer设计提供新思路。

• 生物与AI桥梁:Transformer并非简单工程产物,而是实现了生物进化数百万年优化的基本学习机制,建立了人工智能与神经科学的理论桥梁。

• 局限与未来方向:当前模型与标准softmax注意力存在差异,忽略了竞争性归一化等机制,未来研究需探索非线性动态及多时间尺度学习的协同作用。

Transformer的“注意”实为一种快速动态的条件联想过程,其成功源于捕获了智能本质中的通用计算原则。这一视角不仅深化了对Transformer能力的理解,也为构建更具解释力和生物合理性的AI系统指明方向。

详见全文🔗arxiv.org/abs/2508.08289

Transformer神经网络人工智能机器学习神经科学巴甫洛夫条件反射Hebbian学习线性注意力

![3731近在咫尺,可能还是要去[思考]](http://image.uczzd.cn/17684134692284466799.jpg?id=0)