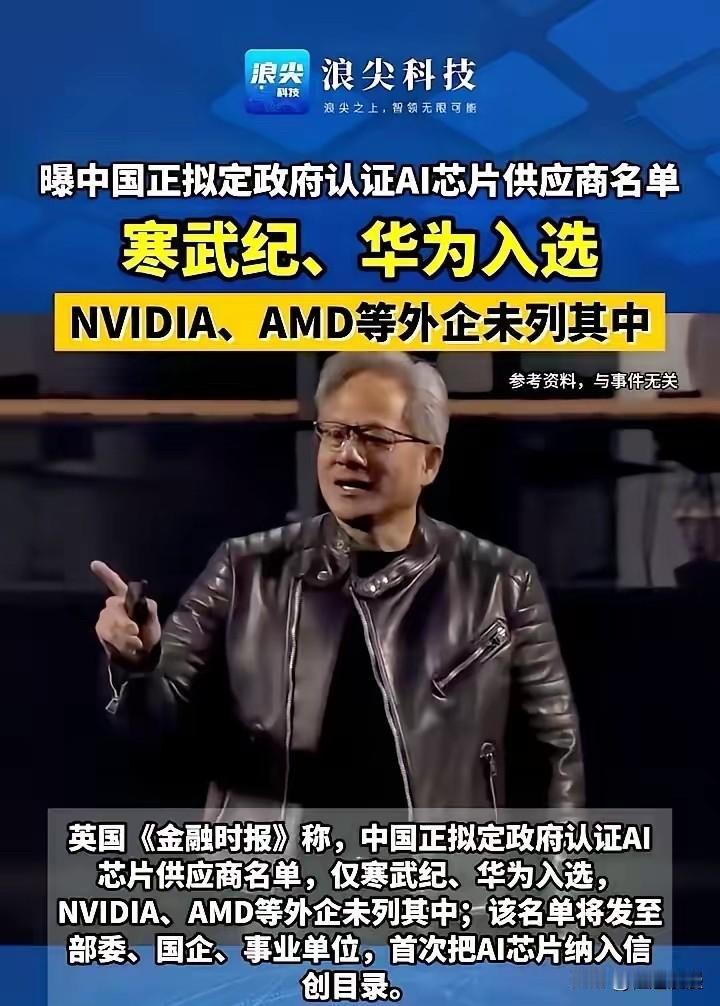

记者问:“中美 AI 差距到底有多大?” 梁文锋毫不避讳、一针见血地回答:“表面上中国 AI 与美国可能仅有一两年的技术代差,但真实的差距是原创和模仿之差。如果这个差距不改变,中国永远只能是追随者,所以有些探索是逃不掉的。” 现在中国AI应用搞得风生水起,刷视频的智能推荐、办公用的AI写作、马路上的安防监控,到处都能看到AI的影子,短视频AIGC渗透率高达70%,比美国的45%还高出一截,论落地能力咱们确实不弱。 可这些光鲜背后,全是别人的技术地基:Transformer架构、Diffusion模型这些AI底层核心技术,全是美国搞出来的,全球高引用的AGI研究成果里美国占4项,咱们才1项。 国内不少企业做AI,就是拿美国的开源框架改一改、调一调,在别人画好的圈子里做优化,看似跑得挺快,实则根本没掌握核心话语权。 就像盖房子,别人打好了地基、定好了图纸,咱们只是负责砌墙装修,哪天人家不让用地基了,咱们的房子说塌就塌。 硬件层面的差距更直白,训练顶级大模型离不开高端芯片,美国英伟达H100芯片的半精度算力达到1979 TFLOPS,是华为昇腾910B的7.7倍,3350 GB/s的显存带宽,更是形成了难以逾越的性能壁垒。 更要命的是英伟达的CUDA生态,已经形成了强技术黏性,开发者迁移成本高达80%,哪怕是性能缩水50%的特供版H20芯片,2023年在华销售额还增长了42%。 咱虽然在推理芯片国产化率上冲到了42%,但训练芯片替代率仍只有15%,训练千亿参数模型时,耗时和电费成本比美国高得多,这种依赖别人核心硬件的追赶,根本算不上真正的超越。 论文和专利数据同样能说明问题,2024年中国AI专利申请量是美国的13倍还多,全球占比高达70%,NeurIPS顶会论文数量,也让清华等高校冲进了全球前列,可数量多不代表质量硬。 美国AI顶会论文引用量占比29.52%,咱们才15.32%,国际上认可的核心专利比例美国高达32%,中国仅4%。 这就像考试,咱们题做得多,但难题、原创题全是美国出的,咱们只是在反复做模拟题,看似分数不错,可一旦遇到没见过的新题型,立马就露怯。 更让人揪心的是人才问题,中国培养了全球47%的顶级AI研究人员,可77%的留美AI博士毕业后选择留美工作,GPT-4团队的核心贡献者中20%是中国人才,却大多服务于美国企业,咱们辛辛苦苦培养的人才,最后成了别人的创新主力,这才是最可惜的。 美国AI的厉害,在于人家是“出题人”,OpenAI、Google DeepMind不断推出新技术定义行业方向,靠“耐心资本”和高校、企业的协同机制,沉下心搞基础研究,光谷歌一家的AI论文发表量就比腾讯、阿里、华为三家加起来还多1.8倍。 而咱们很多企业太急功近利,眼睛只盯着短期应用变现,不愿啃底层技术的硬骨头,科研与产业脱节的问题突出,校企合作多停留在论文层面,知识转移效率低。 这种“重应用、轻原创”的模式,短期内能赚快钱,长期来看却会被人卡脖子,之前美国芯片制裁一来,不少依赖“堆算力”的企业瞬间就陷入了困境,这就是模仿之路的致命短板。 不过咱也不用过分悲观,梁文锋团队的探索已经给出了榜样,DeepSeek就没走“堆算力”的老路,而是在算法优化和技术架构上搞原创,在旧款芯片上实现突破,训练成本不到GPT-4o的1/20,性能却冲进了全球第一梯队。 更关键的是它选择开源,把核心技术敞开分享,三个月就吸引了300%的开发者增长,还带动寒武纪、海光等国产芯片企业升级产品,让奇安信、安恒信息等下游企业的技术能力显著提升,真正形成了“开源扩生态、闭源保核心”的良性循环。 华为昇腾910B,在智慧城市视频分析中能效比反超美国芯片30%,也证明咱们不是没原创突破的能力,只是这样的案例还太少。 中美AI竞争到最后,拼的不是谁应用跑得欢,而是谁能掌握底层原创力。 美国搞“小院高墙”政策限制芯片外流,主导G7 AI监管框架抢占规则话语权,就是想永远当“出题人”;而咱们要做的,就是打破这种垄断,从“答题者”变成“出题人”。 这就需要企业舍得把钱投到基础研究上,别总盯着短期红利;需要建立“学术机构-云厂商-垂类企业”的协同机制,让科研成果真正落地;更需要留住顶尖人才,给他们静下心搞创新的土壤和空间。 梁文锋说“有些探索是逃不掉的”,这话太实在了,原创之路注定布满荆棘,可能要走很多弯路、花很多时间,甚至面临无数次失败,但这是中国AI从追随者变成引领者的必经之路。 靠模仿只能分到一杯羹,靠原创才能掌握话语权,现在DeepSeek的出现已经让我们看到了希望,只要更多企业、更多科研人员沉下心来啃硬骨头,把底层技术、核心架构搞透彻,中国AI迟早能走出自己的原创之路。