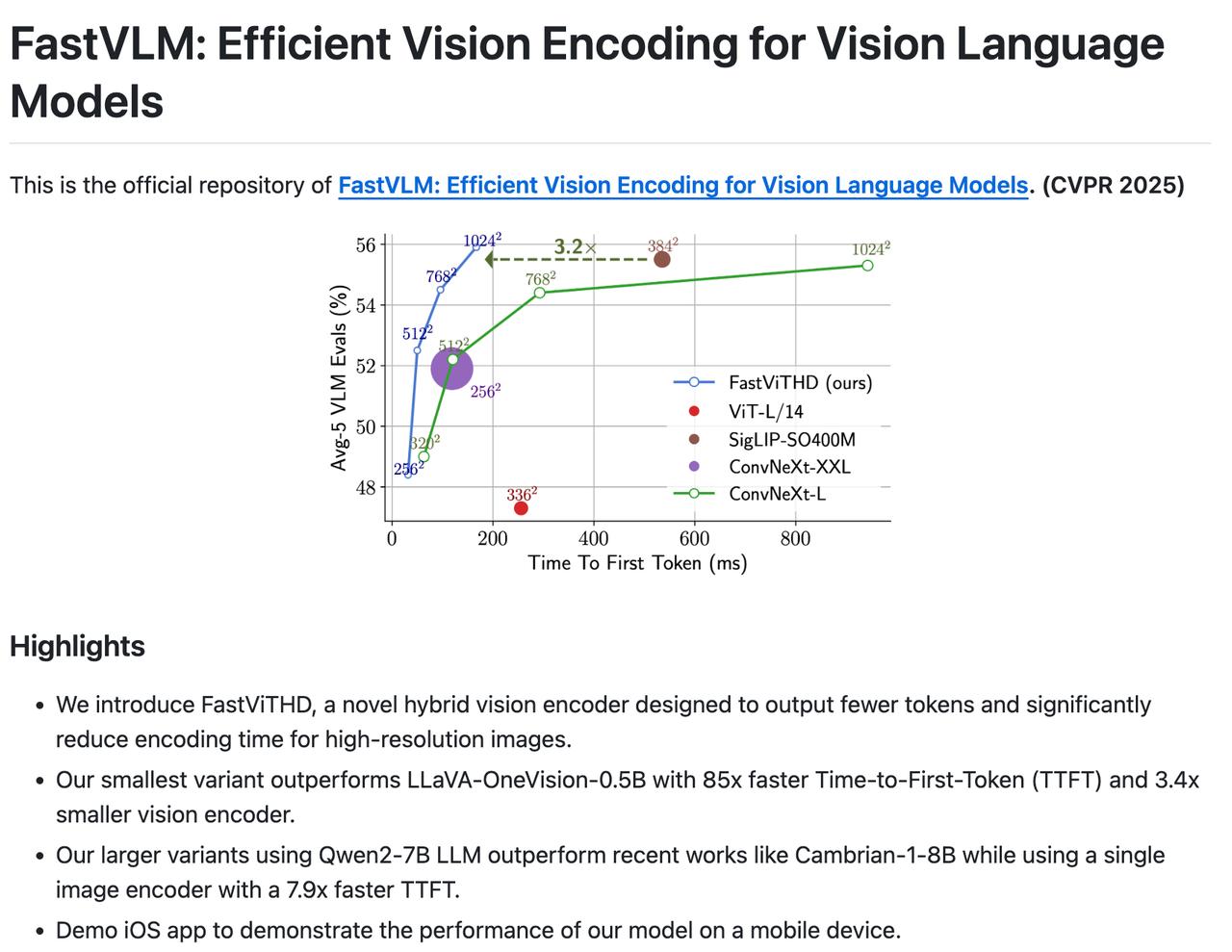

苹果开源了FastVLM:无需联网,即可在iPhone和Mac上运行AI视觉模型,响应还超快。 从苹果的App演示来看,FastVLM可以—— 1、手势识别:对准用户的手部,模型可实时识别举起的手指数量。【图2】 2、图像文字识别:摄像头对准一张便签,FastVLM可在791毫秒内识别出文字信息。【图3】 3、图像描述生成:当模型看到一组emoji表情时,能即时生成英文简述,整个过程控制在800毫秒以内。【图4】 FastVLM的主要技术优势包括: - 视觉token优化:通过减少输出token数量,最多可压缩至原来的1/16,降低了大模型在图像预处理环节的资源消耗。 - 推理速度提升:在关键指标Time-to-First-Token(首次输出延迟)上,FastVLM比LLaVA-OneVision快85倍,响应更即时。 - 模型体积精简:最小规格的FastVLM视觉编码器相比传统模型缩小了3.4倍,而且性能未缩水。 - 原生本地推理支持:模型专为Apple Silicon芯片(如M1、M2)优化,兼容苹果机器学习框架。 架构方面,FastViTHD采用混合结构,结合了卷积和Transformer,配合多尺度下采样,既保留高分辨率信息,又压缩了冗余token。 在多个主流多模态评测基准(如GQA、TextVQA、SeedBench)中,FastVLM全面超越了包括ConvLLaVA、Cambrian-1、MM1在内的多款大模型,且资源消耗更低,推理效率更高。 目前,苹果在开源平台提供了三种模型规格(0.5B / 1.5B / 7B),同时发布了适配Apple Silicon的版本与iOS demo应用,方便开发者快速测试。 代码:-fastvlm 论文: