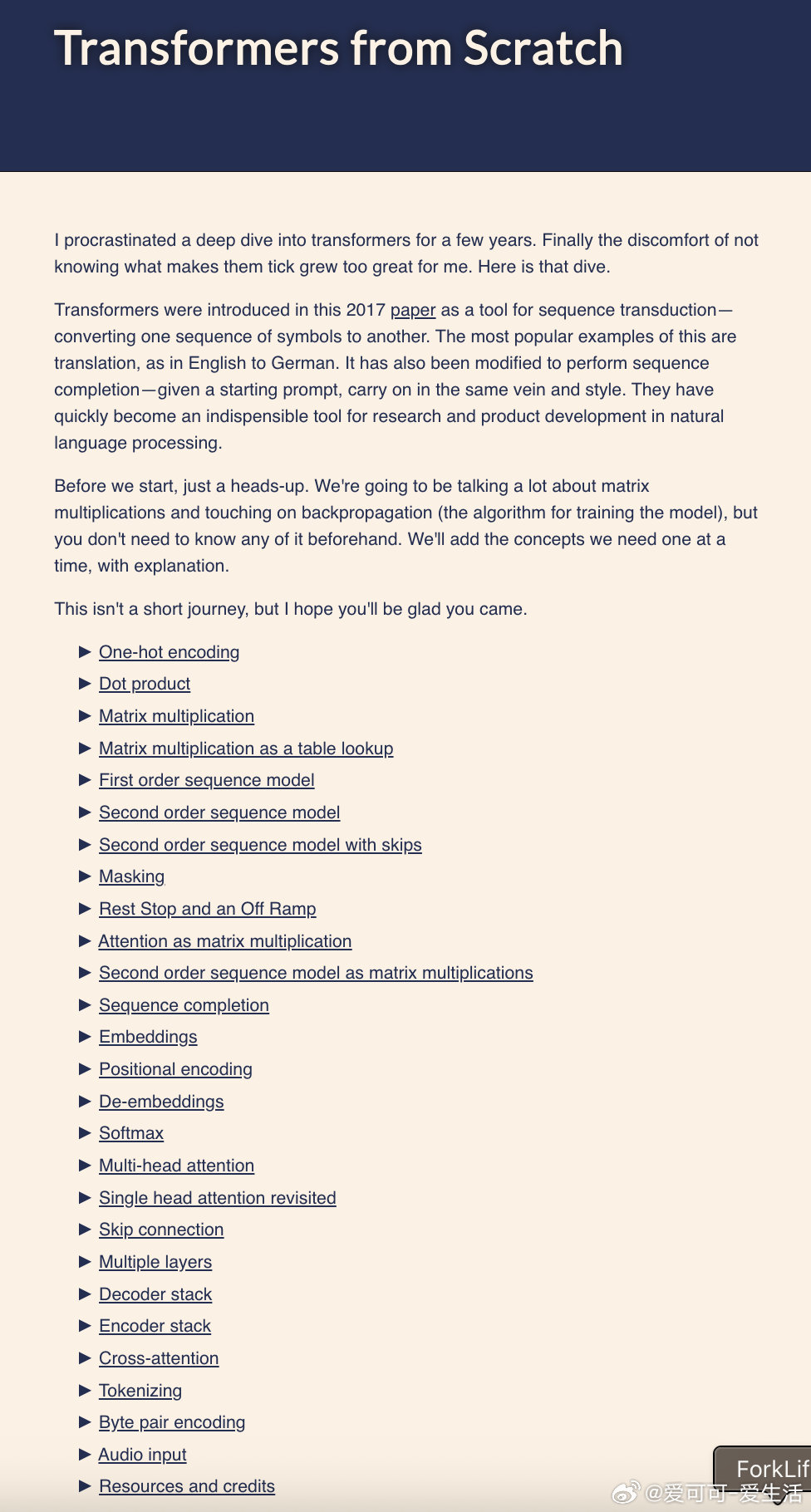

深度理解Transformers,从基础数学到核心机制全覆盖,适合入门深度学习:

• 词语转数字:从独热编码(one-hot encoding)开始,揭示词向量基础。

• 矩阵乘法与查表原理:核心计算机制,支撑高效信息检索与转换。

• 马尔可夫链与序列模型:从一阶到二阶,再到带跳跃的模型,逐步捕捉长距离依赖。

• 注意力机制(Attention):通过掩码(masking)选择关键特征,软化选择的softmax保证模型稳定训练。

• 多头注意力(Multi-head Attention):多视角并行关注,提升表达力与泛化能力。

• 嵌入(Embeddings)与位置编码(Positional Encoding):降低维度,注入序列位置信息,增强上下文感知。

• 跳跃连接(Skip Connections)与层归一化(Layer Normalization):保证训练梯度流畅,提升模型稳定性。

• 编码器与解码器结构:实现序列转换与生成,支持翻译等复杂任务。

• 字节对编码(Byte Pair Encoding):高效分词,兼顾新词与变体,提升语义表达。

• 音频输入预处理:将声音信号转为可嵌入向量,拓展应用边界。

这篇详尽指南不仅讲透Transformer运作原理,更提炼出设计背后的方法论与深层认知,助力构建高效、稳健的自然语言处理模型。

阅读原文,开启你的Transformer深度之旅👉 e2eml.school/transformers.html

深度学习 Transformer 自然语言处理 注意力机制 机器学习