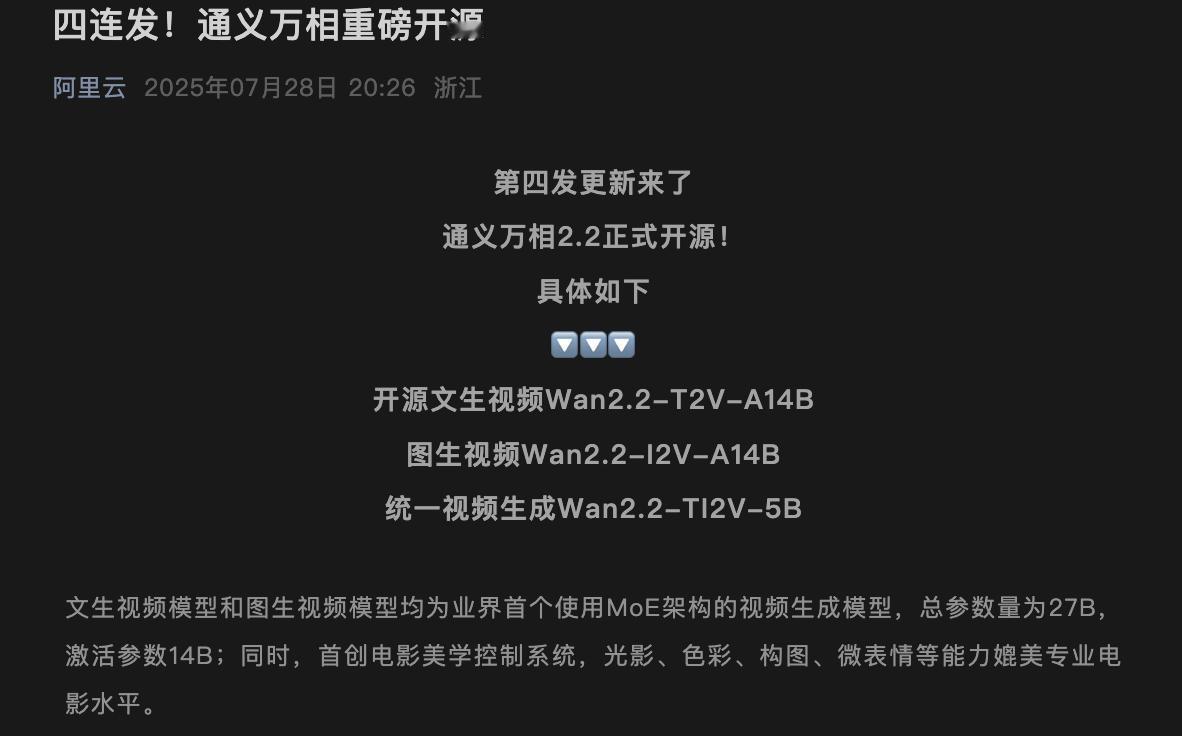

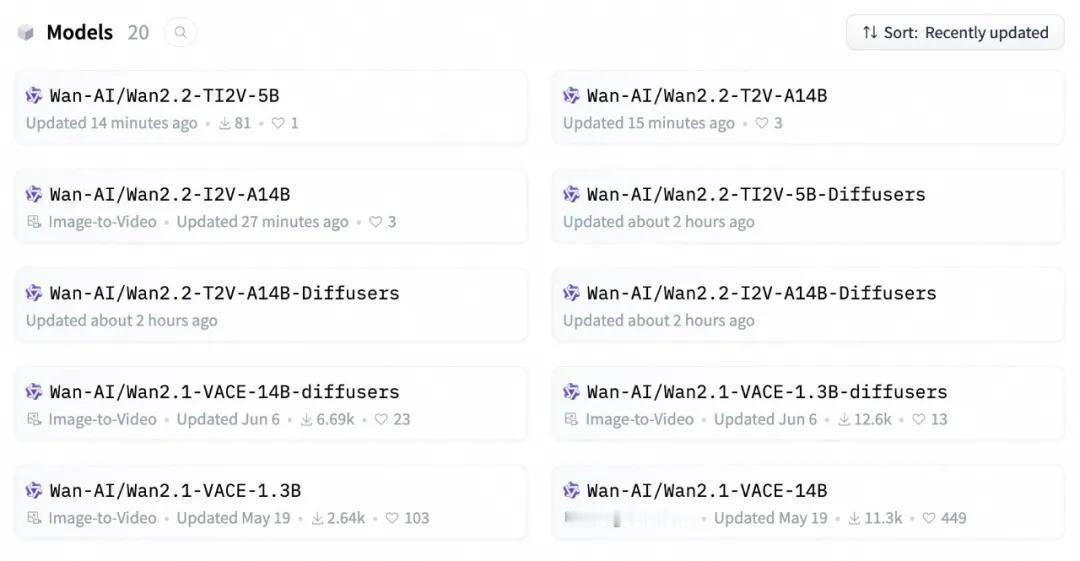

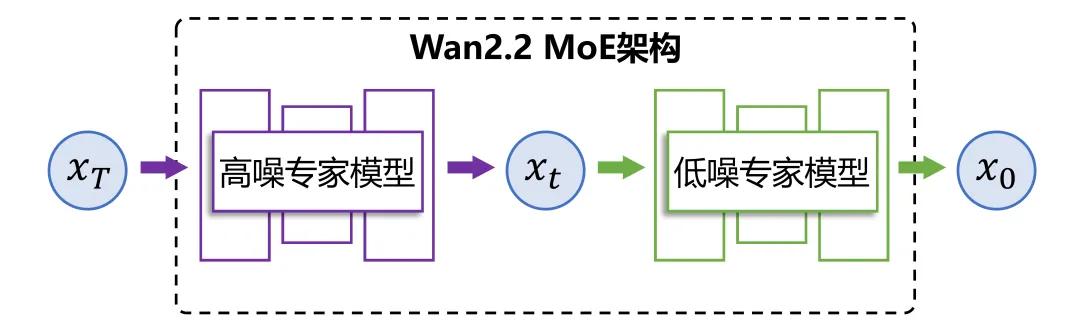

通义万相重磅开源2.2版:文图生视频三模型齐上阵,业内首个视频MoE架构落地来了 阿里通义团队今天一口气开源三款视频生成大模型: · Wan2.2-T2V-A14B(文生视频) · Wan2.2-I2V-A14B(图生视频) · Wan2.2-TI2V-5B(统一视频生成模型) 核心亮点: 1️⃣ 首次引入MoE架构:两款14B激活参数模型分工负责“布局+细节”,推理成本下降约50%,效果覆盖复杂运动、表情、构图等美学层面; 2️⃣ 电影级美学控制系统:支持60+可控参数组合,prompt可指定「柔光」「边缘光」「低角度」「冷色调」等,出片风格直奔电影感; 3️⃣ 单卡可跑的5B小模型:高压缩率3D VAE架构,22G显存可生成720P 5秒高清,适配消费级显卡部署。 可直接下载体验(GitHub / HuggingFace / 魔搭社区),也支持通义官网和App在线生成。 国产文生视频模型最强一轮开源,技术细节实打实,特别是MoE落地和电影感prompt控制,比预期更超前,建议收藏。 🟦 你更关注“推理门槛”还是“画面质量”? 通义万相2.2 ai视频生成 开源模型 MoE架构优化 文生视频

![阿里的IT程序员吐槽QQ技术太差,腾讯员工也只能尴尬回应。[捂脸哭]](http://image.uczzd.cn/14377306799521986243.jpg?id=0)