deepseek v3 要明白中国AI的突破,需要先搞懂Transformer。整理了下,学习30个简单概念就行了

有些是语文,例如NLP、向量、张量。有些是简单的数学处理,基本是加减乘除的简单处理,对矩阵和向量。还有些是某种神经网络结构,其中RNN相关的概念是核心,Attention注意力机制就是从里面出来的。所以把RNN和Attention学下,就有搞懂的基础了。这两个概念算难一些,其它都简单。

搞懂了Transfomer和大模型训练机制,再来看deepseek v3的论文,就没那么难了。

但是由于概念还真比较多,一般人不知道从哪学起。虽然每个概念都不复杂,但是加一起就让人晕头转向了。其实就是耐心学习,把名词体系搞懂就行了。比芯片简单,那边专业的要上千个名词。

NLP自然语言理解

Seq2Seq 序列转换

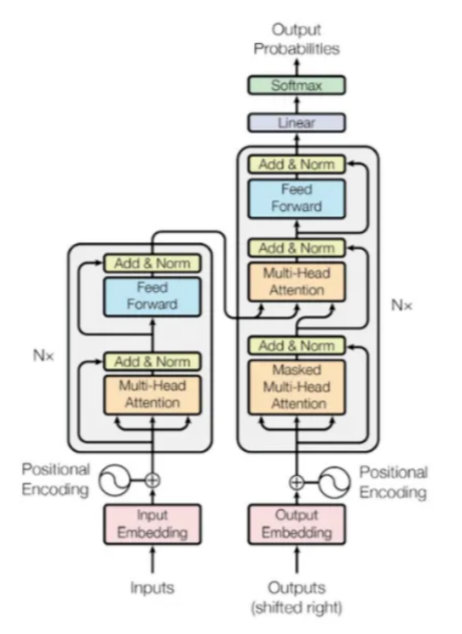

Encoder-Decoder 机器翻译架构

RNN循环神经网络

Attention注意力机制

Feed-Forward Network 前馈神经网络

Vector/Tensor 向量、张量

Embedding 词嵌入算法

Self-Attention自注意力

Softmax 概率归一化函数

ReLU 一种激活函数

Dot-Production 矩阵点积

Scale 缩放

Scaled Dot-Production Attention 缩放点积注意力

Query 查询矩阵

Key 键矩阵

Value 值矩阵

Multi-Head Attention 多头注意力机制

Concat 拼接

Normalization 归一化

Residual connection 残差连接

Positional Encoding 位置编码

Encoder-Decoder Attention 解码器注意力机制

Linear 线性全连接层

Embedded Layer 嵌入层

Output Layer 输出层

Padding mask 填充掩码

Sequence mask 序列掩码

Logits 原始分数

Dropout 丢弃防止过拟合

Label smoothing 标签平滑软标签