生成式人工智能的崛起,正推动数据中心设计迎来颠覆性变革。从英伟达最新 GPU 平台引发的硬件升级开始,这场变革已逐步演变为全栈基础设施层面的挑战。如今,超大规模数据中心运营商纷纷部署机架密度超 100kW 的 AI 超级计算机,这一趋势也迅速影响到主机托管服务提供商与企业数据中心。

在当下工作负载要求攀升、部署时间紧迫、灵活性至关重要的时代,数据中心建设的核心已不只是追求更强性能或更快芯片,而是要解决如何高效冷却、灵活扩展与快速部署基础设施的关键问题。

一、AI 时代的数据中心密度困境

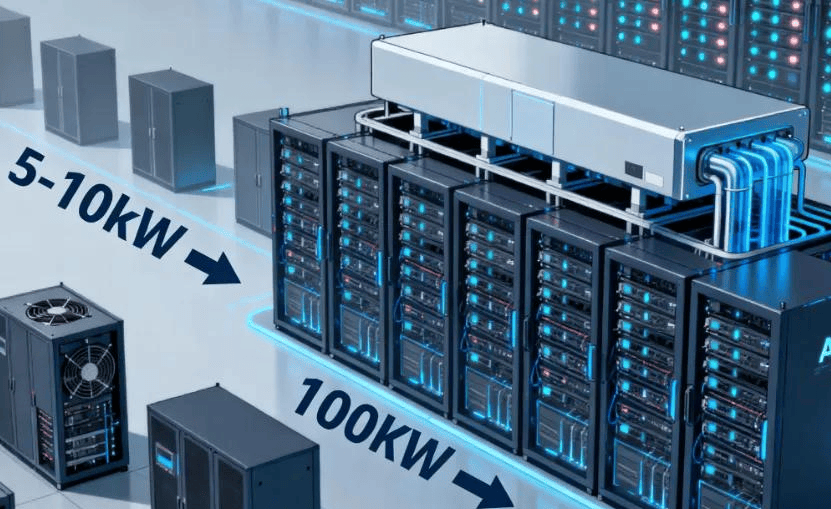

传统主机托管环境的设计,多围绕 5-10kW 的风冷机架展开。然而,随着 AI 技术的发展,这一模式已完全无法满足需求。AI 工作负载,特别是涉及大型语言模型(LLM)、计算机视觉及实时推理的场景,需要紧密集成的 GPU 集群支持,这直接导致机架密度飙升至 100kW 以上。更有预测显示,未来几年内,随着多机架 GPU 集群集成度进一步提升,且液冷成为行业标准,每机架密度甚至可能达到 1MW。

密度的爆炸式增长带来了严峻的散热挑战,仅依靠传统空气冷却技术已难以应对。液体冷却逐渐从 “可选配置” 转变为 “必需方案”,但将整个机房改造为液体冷却系统,不仅成本高昂,还会对现有运营造成干扰,且耗时漫长,并非理想之选。

二、智能解决方案

面对散热难题,机架级遏制凭借其独特优势,成为当前最具前景的应对策略之一。这种设计方法在机架级别实现冷热区域的隔离,无需对整个机房进行重新设计,就能满足超高密度冷却需求。对于运营商而言,这意味着可以在现有设施中直接部署高性能基础设施,大幅缩短计算资源上线时间,同时降低资本支出。

更重要的是,机架级密封系统支持空气冷却与液体冷却共存的混合冷却架构。这一特性对两类运营商尤为关键:一类是需要同时支持传统与 AI 混合工作负载的企业,另一类是计划逐步过渡到全液冷系统、避免一次性大规模改造的服务商。

三、适配设计要点

除了冷却能力,主机托管服务提供商还需从快速部署、模块化与安全性角度,优化基础设施设计,以匹配 AI 企业的高速发展节奏,满足其对基础设施合作伙伴的高效响应期望。具体而言,核心设计考虑因素包括以下四点:

模块化部署选项:提供可快速安装的滚入式或固定式机架,无论是新建数据中心,还是对现有环境进行改造,都能实现高效部署,缩短基础设施上线周期。

环境弹性适配:设计适用于室内外多种场景的机柜(如符合 NEMA 3R 标准的机柜),支持将数据中心部署在边缘位置或非常规场地,满足 AI 在多场景下的应用需求。

集成安全防护:随着电力密度提升,数据中心的安全风险也随之增加。因此,在高密度机架中内置灭火系统,成为保障运营安全的关键配置。

未来适配能力:基础设施需具备灵活调整空间,以适应不断更新的 GPU 架构、电力传输标准及冷却技术,避免因技术迭代导致的设施淘汰问题。

四、未来发展路径

人工智能不仅重塑了计算模式,更改变了支撑 AI 运行的基础设施的构建与运营逻辑。对于主机托管服务提供商来说,清晰的发展机遇已然显现:紧跟技术变革节奏,采用模块化与机架级冷却策略,同时兼顾基础设施的灵活性、安全性与可扩展性。

▌▌▌▌▌▌▌▌▌▌

下一代数据中心的竞争力,将不再由建筑面积大小或传统冷却系统的规格决定,而是取决于从现在开始,能否构建出支持未来工作负载的基础设施体系。