机器人学会预测未来

不得了,机器人现在开始学会脑补未来了。

这就是蚂蚁灵波又又又又(连续第4天)开源的狠活儿——

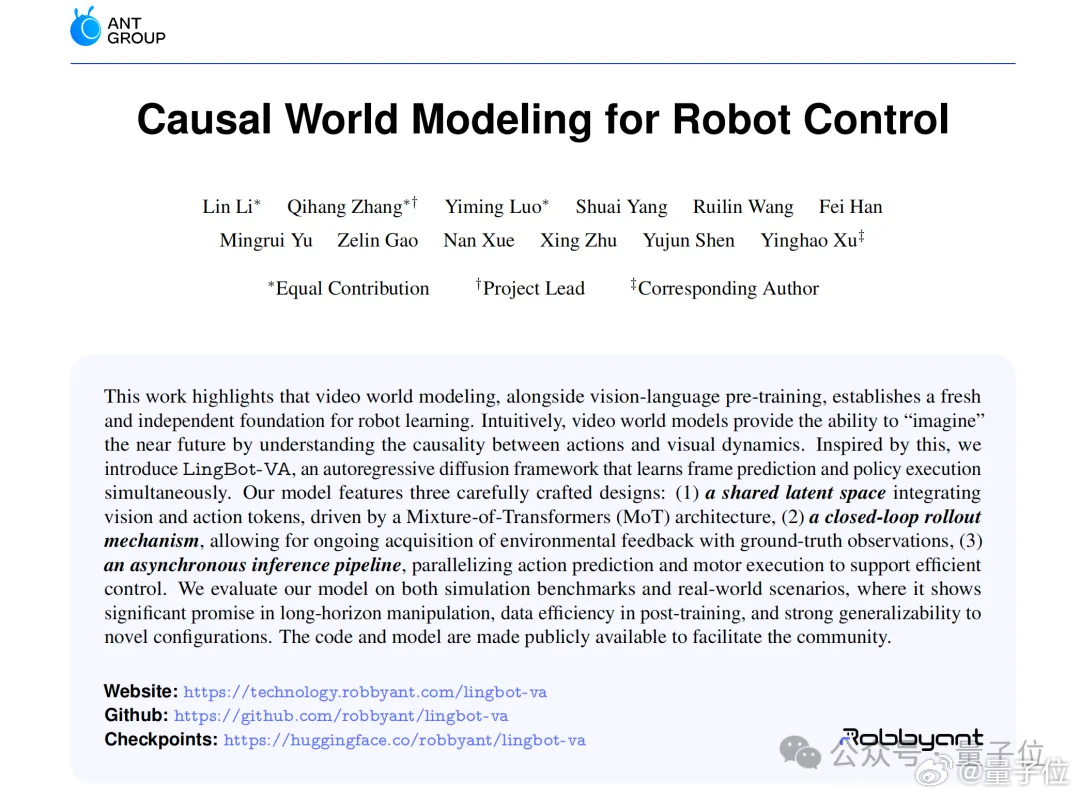

全球首个用于通用机器人控制的因果视频-动作世界模型,LingBot-VA。

怎么个脑补法?

简单来说啊,以前的机器人(尤其是基于VLA的)干活儿,主打一个条件反射:眼睛看到什么,手立刻就动一下。

这叫“观察-反应”模式。

但LingBot-VA就不一样了,它通过自回归视频预测打破了这种思考方式,在动手之前,脑子里先把未来几秒的画面推演出来。

说实话,用想象力做决策,在机器人控制这块还是相当新鲜的。

但这不是LingBot-VA唯一的亮点,还包括:

- 记忆不丢失:做长序列任务(比如做早餐)时,它会记得自己刚才干了什么,状态感知极强。- 高效泛化:只要给几十个演示样本,它就能适应新任务;换个机器人本体,也能hold住。

因此在LingBot-VA的加持下,像清洗细小的透明试管这种高精度任务,机器人已经是可以轻松拿捏:

正如我们刚才提到的,今天是蚂蚁灵波连续第四天开源。

如果说前几天的开源是给机器人加强了眼睛(LingBot-Depth)、大脑(LingBot-VLA)和世界模拟器(LingBot-World),那么今天的LingBot-VA,就是让这具躯壳真正拥有了灵魂——

一个行动中的世界模型,让想象真正落到执行层面。

如此一来,通用机器人的天花板,算是被蚂蚁灵波往上顶了一截。

正如网友所述:“从预测到执行;说实话这是巨大的飞跃。”网页链接