IT时报记者郝俊慧

“Whynotfindafuturewecanlookforwardto(为什么不共同追寻一个值得奔赴的未来)?Whynotdevelopmore,imaginemore,curemore(为什么不更多创新、更多想象、更多治愈)?”2025年12月初,亚马逊云科技(AWS)用一连串“Whynot?”拉开了第14届re:Invent的序幕。

即便是亚马逊云科技这样一个“久经沙场”的巨头,2025年都称得上是它“不可思议”的一年,Q3财报数据显示,营收同比增长超20%,全年营收可能超过1320亿美元,而为了支撑这种增长,亚马逊在2025年的资本支出(CapEx)预计将达到创纪录的1250亿美元。

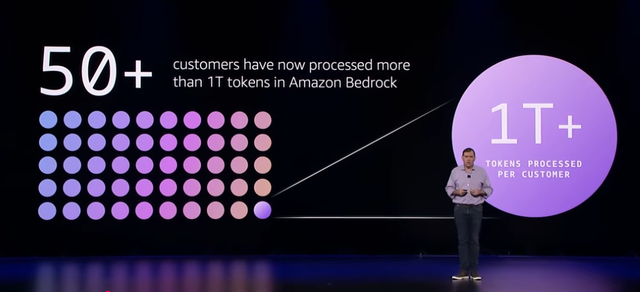

在生成式AI的浪潮中,AWS加速增长。数据显示,AmazonBedrock平台服务的客户在一年内翻了一倍,其中tokens处理数量超万亿规模的客户已经超过50家。

由此,很容易理解为何在全球AI产业处于“拐点时刻”的关键之年,亚马逊云科技发问:为什么不重构整个社会创新的底座?

Whynot?

全栈自研的“野心”:突破硬件极限

没有一家AI基础设施巨头甘心永远只买英伟达的“铲子”。

英伟达2025财年第三季度财报显示,毛利率高达74.6%,净利润同比增长109%。可对比的数据是,硅谷七巨头(谷歌、微软、AWS、苹果、特斯拉、Meta、英伟达),每年合计资本支出(CapEx)已超过2000亿美元,其中绝大部分是AI基础设施投入。

“你需要的是一个拥有强大可拓展性的基础设施,它有着最佳性能和最低成本,想达到这个目的,就必须优化从软件到硬件的全栈流程,而这些恰恰只有亚马逊云科技能够做到。”2025亚马逊云科技re:Invent中国行北京站上,亚马逊云科技大中华区产品部总经理陈晓建开门见山。

AWS的梦想是“突破基础设施可能性的极限”,这需要对从硅片、固件、网络到软件框架的每一层进行垂直整合,在本次re:Invent上,AWS展示从基础芯片、计算实例、模型平台到应用工具的完整技术栈。

最核心的自然是芯片。陈晓建透露了亚马逊云科技自研训推芯片AmazonTrainium3的最新迭代方向和落地案例。

Trainium3是AWS首款基于3nm工艺的芯片,提供比Trainium2高4.4倍的计算性能、更高的能效(提升40%)、内存容量增加1.5倍(144GBHBM3e)、带宽提升1.7倍,支持大规模UltraServers(单个服务器最多144个芯片)和UltraClusters(可扩展至数十万甚至上百万芯片)。

自研芯片的好处显而易见。

即使不考虑英伟达的“垄断溢价”,单从架构上看,ASIC架构的Trainium3也天然会比通用架构的英伟达GPU便宜。ASIC是专为AI训练(矩阵乘法、梯度计算、注意力机制等)设计的芯片,内部只包含必需的计算单元(如大型NeuronCores、专用集体通信引擎)、高带宽HBM内存和优化数据路径,不需要多余的图形渲染、游戏优化或通用计算模块,因此可以在固定AI任务上实现更高性能密度和能效,也就是排除所有多余功能,“专心只做一件事”。

据透露,Anthropic、Karakuri、Metagenomics、Neto.ai、Ricoh与SplashMusic等客户都已经通过Trainium将训练与推理成本降低至原来的50%。

“两年前,基于Trainium芯片的大模型训练与推理部署还要进行独立适配调试,但现在Trainium的通用性已大大增强,今年第一季度还会支持更多的PyTorch高级语言,未来最终会形成类似于AmazonGraviton(ARM架构)与X86架构并存的局面,客户可以根据自己的综合需求选择芯片。”亚马逊云科技大中华区解决方案架构总经理代闻特别指出,AnthropicClaude最新一代模型的所有流量都已经跑在了AmazonTrainium上面。亚马逊云科技迄今已部署超过100万颗Trainium芯片。

目前AmazonTrainium的业务规模已有数十亿美元,尤其在AmazonBedrock平台上,绝大部分推理服务已可以通过AmazonTrainium实现。

陈晓建在演讲中还透露了下一代产品Trainium4的规划:相比AmazonTrainium3,Trainium4将提供6倍的FP4计算性能、4倍的内存带宽、2倍的内存容量,以及2倍的能效提升。

当然,亚马逊云科技的自研野心不仅仅局限于算力芯片。从2017年开始投入自研芯片,AWS目前已经形成三条产品线:基于Arm架构的Graviton系列负责通用计算、Trainium和Inferentia专攻AI训练与推理、Nitro系统芯片则负责将网络、存储和安全功能从主CPU中卸载。

除此之外,从芯片到实例计算,从存储到数据库,从训练到推理,亚马逊云科技正在构建一个闭环的AI基础设施。

本次re:Invent上,亚马逊云科技发布了一个新产品——AmazonAIFactory(亚马逊AI工厂),这是一个私有的AWS区域,让客户能够利用自己的数据中心和电力容量,由AWS帮助建设最先进的AI基础设施。

该方案包含最新的NVIDIAGPU、AmazonTrainium芯片,以及AmazonSageMaker和Bedrock平台。AI工厂为每个客户独立运营,确保资源和业务的完全隔离,同时保持与AWS相同的安全性和可靠性。这种模式实际上是在帮助那些因建立起数据主权、监管合规等重要因素而无法公有云的客户,将“云”迁移到他们的本地环境中。

“今后,单个数据中心不再是一台新计算机,而是整个数据园区变身为一台新计算机。当你能够同时优化硬件设计、虚拟化层、网络、框架架构、模型服务的每一个环节时,整体的优势将会呈指数级放大。”陈晓建表示。

对大模型“祛魅”Agent落地“推拉结合”

2025年被称为Agent元年。如果说基础设施是土壤,是亚马逊科技对于成为超级AI基础设施的野心,那么,Agent(智能体)是这块土地上最丰硕的果实,推动Agent落地,是AWS一向的“务实”方法论——逆向工作法,以客户需求定产品。

越来越多的企业意识到,至少在现阶段,不存在一个“包打天下”的大模型,企业的知识和流程才是核心资产,而Agent则是将这些资产转化为生产力的工程化手段。

对大模型“祛魅”之后,客户不再纠结用哪个模型,而是更关注如何界定AI和人类之间的关系:哪些重复性工作可以交给AI去做,而人应该去做什么?

目前,亚马逊内部在用Agent已经超过4万个。在与Agent的共事中,代闻发现,工具的更迭只是表象,生产关系的重构才是核心。首先是组织形态的重构。当人机协作成为常态,传统的线性管理模式失效,企业必须在全新的协作范式下,建立一套匹配AI生产力的组织方法论;其次是角色边界的重塑,随着个体职能向“AI指挥官”转变,配套什么样的工具便至关重要。

代闻举了两个具体的例子:第一个是销售(BD)场景。以前销售在拜访客户前,通常要查阅大量资料并请经理Review,现在经理可以利用AmazonQuickSuite直接生成一份详尽的报告(CallPlan或AccountPlan),它能自动搜索客户最新的上市信息、舆情,并总结内网历史交易数据(比如涉及销售更替时的历史记录),这种跨越公网和内网的信息量整合,对以前而言是成倍的效率提升。

第二个是开发场景。产品经理(PM)以前想要验证一个想法,通常要等研发排期做原型,因为PM大多写不了代码,现在有了AI,PM相当于随时可以“召唤”一名AI工程师协助制作原型。这种“解耦”让PM可以先独立完成原型的制作与确认,再交给研发团队去正式实现。

“流程的重构和组织形式的变化,才是效能提升的关键。如果工具到位了但流程没变,开发人员写得再快,后面依然会卡住。”代闻认为,真正推动这种深层的变革,通常需要Top-down(自上而下)的支持。

据他观察,目前企业拥抱AI主要有两种模式:一种是在内部成立小规模的新团队(比如几十人的规模),让他们充分拥抱AI原生的工作状态,例如AWS的合作伙伴猎豹移动就成立了新的AI开发团队,他们对成员的首要要求是对AI有热情,甚至对学历都没有硬性要求,这种模式其实就是在尝试一种全新的工作状态;另一种模式是对原有的开发团队进行逐步转型,但这需要强有力的制度指引,需要改变原有的KPI考核方式,但如果你只让他负责而不给他工具,这事儿也很难推下去,因此需要“推”“拉”结合:“推”是新的KPI设计,“拉”就是提供好用的工具支持。

“Theworkisyours,notthetools.(工作属于你,而不是工具)。”或许对每一个打工人来说,这种对AI认知的“自驱力”将在未来变得更加重要。