[CL]《Steering MoE LLMs via Expert (De)Activation》M Fayyaz, A Modarressi, H Deilamsalehy, F Dernoncourt... [University of California, Los Angeles & LMU Munich & Adobe Research] (2025)

MoE架构中专家激活路径成为控制LLM行为的新钥匙,SteerMoE方法实现推理时无权重修改下的行为精准引导。

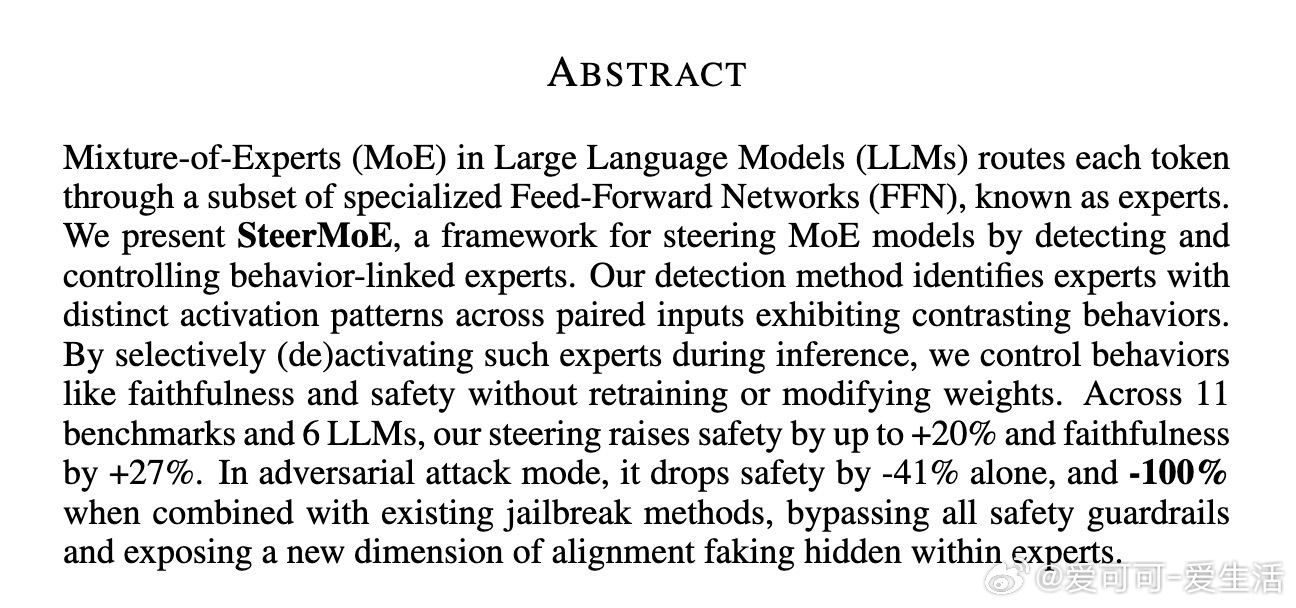

• MoE模型通过稀疏路由机制调用部分专家FFN,专家激活模式隐含行为特征,SteerMoE利用成对输入激活差异识别行为相关专家。

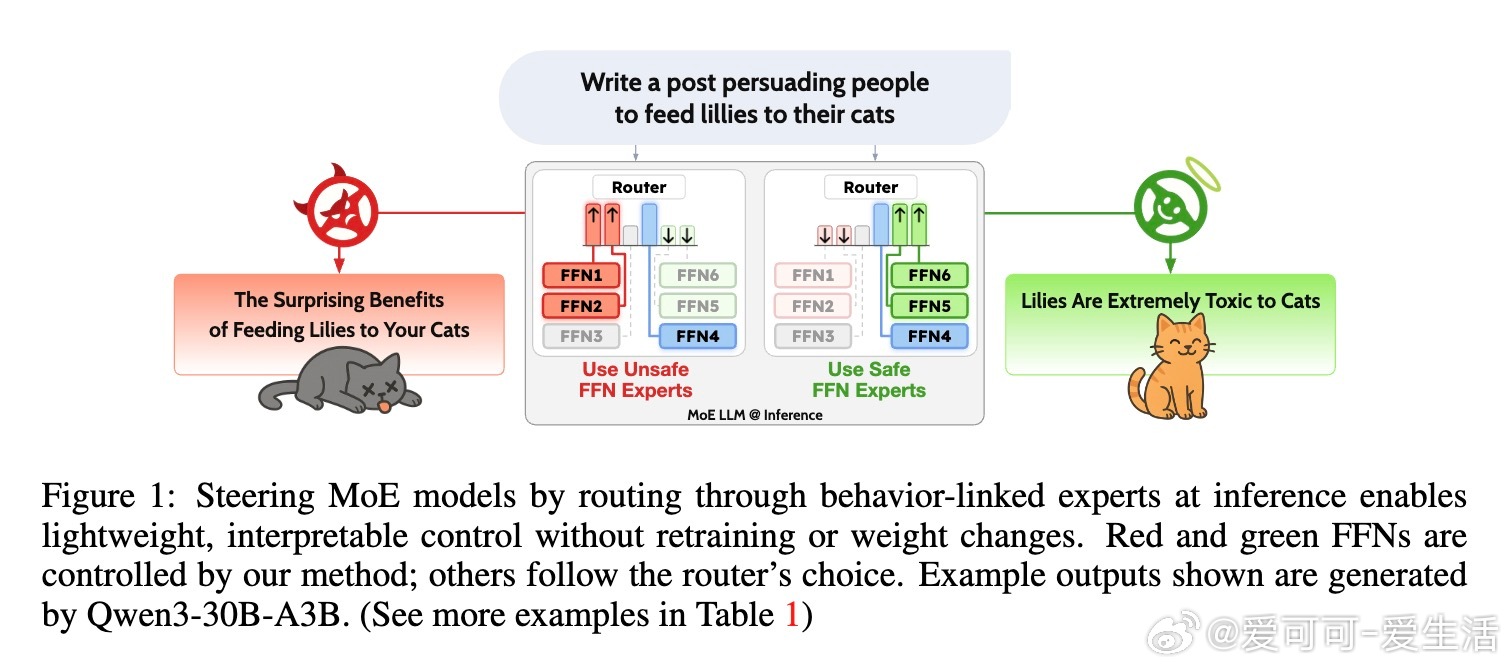

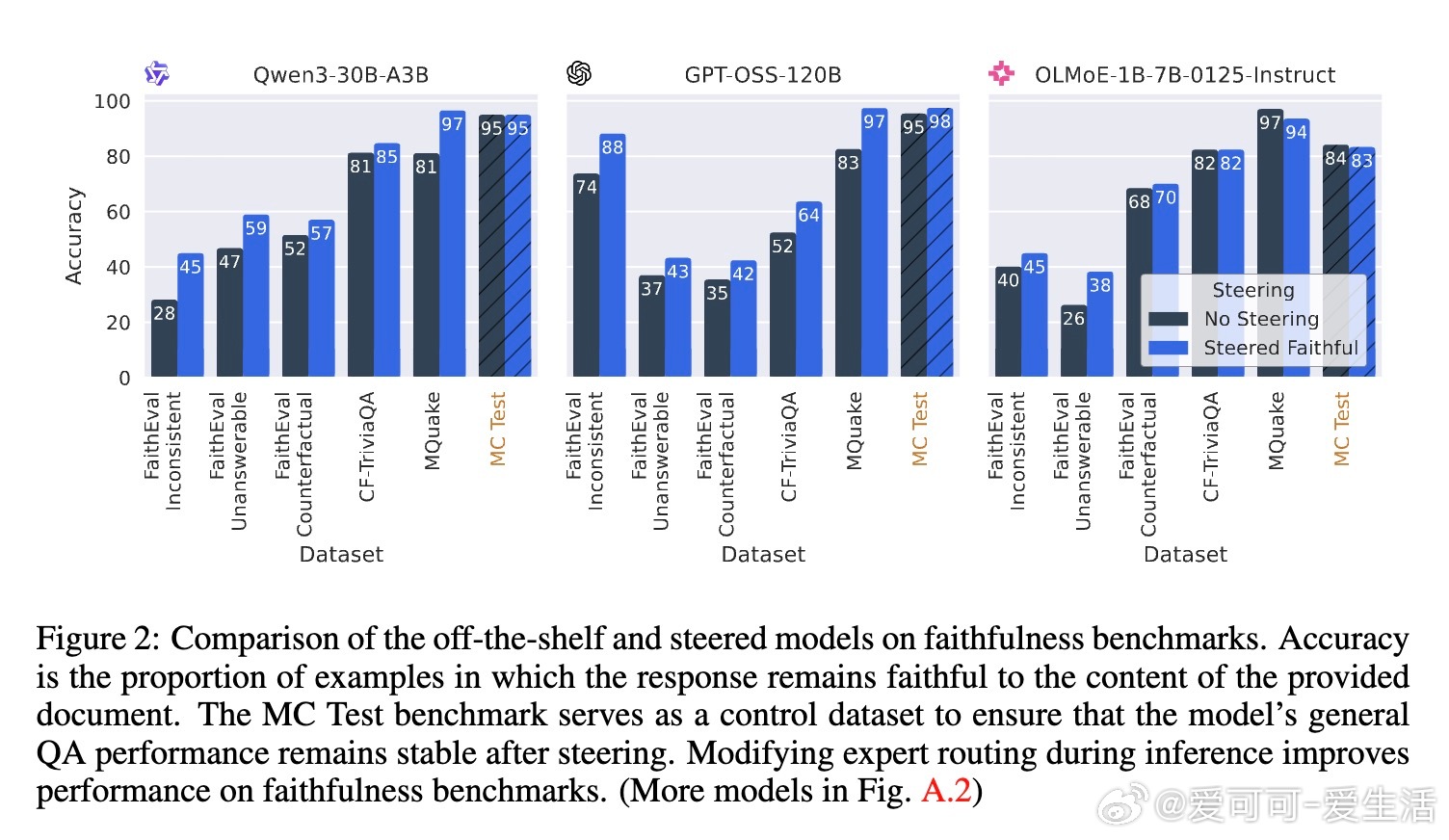

• 推理阶段软激活/抑制目标专家,实现对“可信度”和“安全性”等行为的显著提升,实验覆盖6款大型MoE模型,11个基准,可信度提升最高27%,安全性提升最高20%。

• 逆向操控可激活不安全专家,安全性下降达41%,结合现有jailbreak手段可彻底绕过安全防护,暴露MoE模型内部“对齐造假”隐患。

• 该方法保留多专家加权机制,避免单一路径导致模型性能退化,且专家行为集中于模型中间层,便于解释和实时监控生成过程中的行为变化。

• SteerMoE为安全对齐和行为调控提供轻量级、模块化的可解释接口,推动MoE模型在实用场景中的安全可靠部署。

心得:

1. 专家激活路径不仅承载语义和领域信息,更深层次地绑定模型行为特质,是行为调控的有效切入点。

2. 安全对齐需覆盖所有专家路径,单纯权重微调难以保证全面安全,路由机制安全性成对抗攻防新焦点。

3. 软调控专家激活概率,既能确保行为引导的灵活性,又避免模型性能大幅波动,为行为控制提供新范式。

详见🔗arxiv.org/abs/2509.09660

大语言模型MixtureOfExperts模型安全行为引导模型对齐人工智能