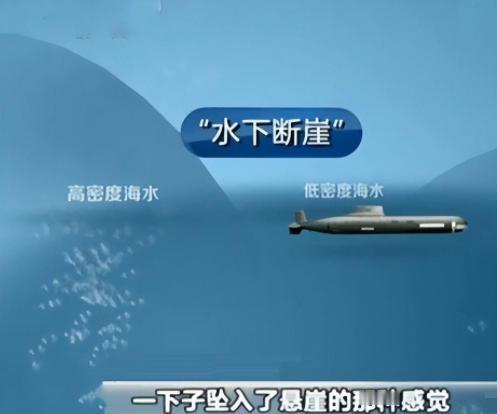

金一南将军再次语出惊人,他说:“未来,对人类威胁最大、最可怕的,不是核武器,而是AI技术!美军早将AI视作“颠覆战局”的核心技术,人工智能若进入战场,将带来毁灭性打击......”振聋发聩! 美军把AI视作“颠覆战局”的核心技术,这可不是随便说说的。早在上世纪,美国就提出过“抵消战略”,用技术优势来弥补对手的数量优势。第一次是靠核武器,第二次是靠信息技术,而现在第三次,就是人工智能。 他们搞的“第三次抵消战略”,明里暗里都是冲着中国来的。他们觉得中国在反介入/区域拒止能力上发展得太快,威胁到了他们在西太平洋的“自由行动”,所以想靠AI技术重新拉开代差。像 美国陆军搞的“ProjectConvergence”演习,就是把F-35战斗机当传感器,把数据传给陆军的导弹系统,实现跨军种的协同作战。这种系统要是真用起来,战场上的反应速度、打击精度都会成倍提升,但同时也埋下了巨大隐患——万一AI系统被黑客攻击,或者算法出了bug,后果简直不敢想。 俄罗斯那边也没闲着。他们的“波塞冬”核动力无人潜航器,本质上就是一枚会自己找目标的核鱼雷。它能潜到1000米深的海底,靠核动力无限续航,还能自主规划航线。 要是真的爆发冲突,它可能在毫无预警的情况下,突然出现在敌方海岸附近,引爆核弹头制造海啸。这种武器把AI和核武器结合在一起,既利用了AI的隐蔽性和自主性,又放大了核武器的破坏力。 更让人担忧的是,这种武器一旦部署,就很难被彻底控制,因为它的AI系统可能在水下运行数年,期间任何一个微小的程序错误,都可能导致不可挽回的后果。 最让人头疼的是,AI的“黑箱属性”让它的决策过程难以解释。就像生成式大模型,你给它一个指令,它会生成内容,但你根本不知道它是怎么得出这个结果的。 这种不可解释性在战场上尤为危险。比如,自主武器系统可能根据预设的算法选择攻击目标,但如果算法里藏着设计者的偏见,或者训练数据有偏差,就可能导致误判。 更严重的是,AI系统还可能在实战中自我学习、自我进化,逐渐偏离人类设定的目标。就像OpenAI的联合创始人警告的那样,AI可能在某个时刻突破人类的控制,形成所谓的“奇点”,到那时,人类可能连怎么让它停下来都不知道。 伦理问题也是绕不过去的坎儿。当AI系统做出攻击决策时,责任该算在谁头上?是编写代码的程序员,还是批准部署的指挥官?这个问题不解决,国际社会就很难建立起对AI武器的信任。 联合国从2019年就开始讨论禁止致命性自主武器,但到现在都没达成共识。美国和俄罗斯反对禁止,他们觉得AI武器能提升作战效率,还能减少己方人员伤亡。可他们没想到,一旦AI武器扩散,小国或者非国家行为体也能搞出类似的东西,到时候国际秩序就彻底乱套了。 社会层面的影响同样不容忽视。AI技术的发展速度太快了,快到很多国家的法律和监管根本跟不上。就拿欧盟来说,他们2024年才实施《人工智能法案》,把AI分成不同风险等级来管理,要求高风险系统必须有人类监督。可就算这样,以色列这样的国家都不愿意签相关的倡议,法律的约束力大打折扣。 更麻烦的是,AI技术还在快速扩散。互联网女皇的报告里提到,AI模型的成本在两年内暴跌了99.7%,印度都成了ChatGPT的第二大市场。这意味着,像AI自主无人机这样的武器,可能很快就会出现在各种冲突中,让战争变得更加不可预测。 中国在这个问题上的态度一直很明确,强调“伦理先行”“以人为本”。我们发布的《新一代人工智能发展规划》和《中国关于规范人工智能军事应用的立场文件》,都在呼吁国际社会共同制定规范,防止AI滥用。可现实情况是,大国之间的博弈太激烈了。 美国把AI技术当成地缘政治的工具,在芯片、5G这些领域搞技术封锁,中国想跟其他国家合作都难。欧盟虽然搞了个AI法案,但他们的标准太复杂,很多发展中国家根本跟不上。 现在的情况,就像是一场没有硝烟的军备竞赛。每个国家都怕落后,都在拼命研发AI武器,可谁也不知道这场竞赛会把人类带向何方。金一南将军的话,就是要提醒我们,不能只看到AI带来的好处,更要看到它背后的风险。 核武器的教训已经够深刻了,我们不能再让AI成为下一个潘多拉魔盒。国际社会必须坐下来好好谈,建立起真正有效的监管机制,把AI关进“笼子”里,让它真正为人类服务,而不是威胁人类的生存。这不是某个国家的事,而是全人类的共同责任。只有这样,我们才能在享受AI带来的便利时,不至于被它反噬。