Agent成败关键上下文工程

什么是上下文工程,居然关系到Agent成败?

过去用AI,总离不开Prompt Engineering(提示词工程)。但现在,一个更重要的新概念正快速兴起:Context Engineering(上下文工程)。

相比只靠一句Prompt来指挥AI,上下文工程在构建一个完整的“信息空间”,让AI真正理解任务、做出更聪明的决策。

有人说,Agent的失败,大多不是模型不够强,而是上下文给得太差。

而上下文工程,就是筛选要给LLM输入哪些上下文的过程。

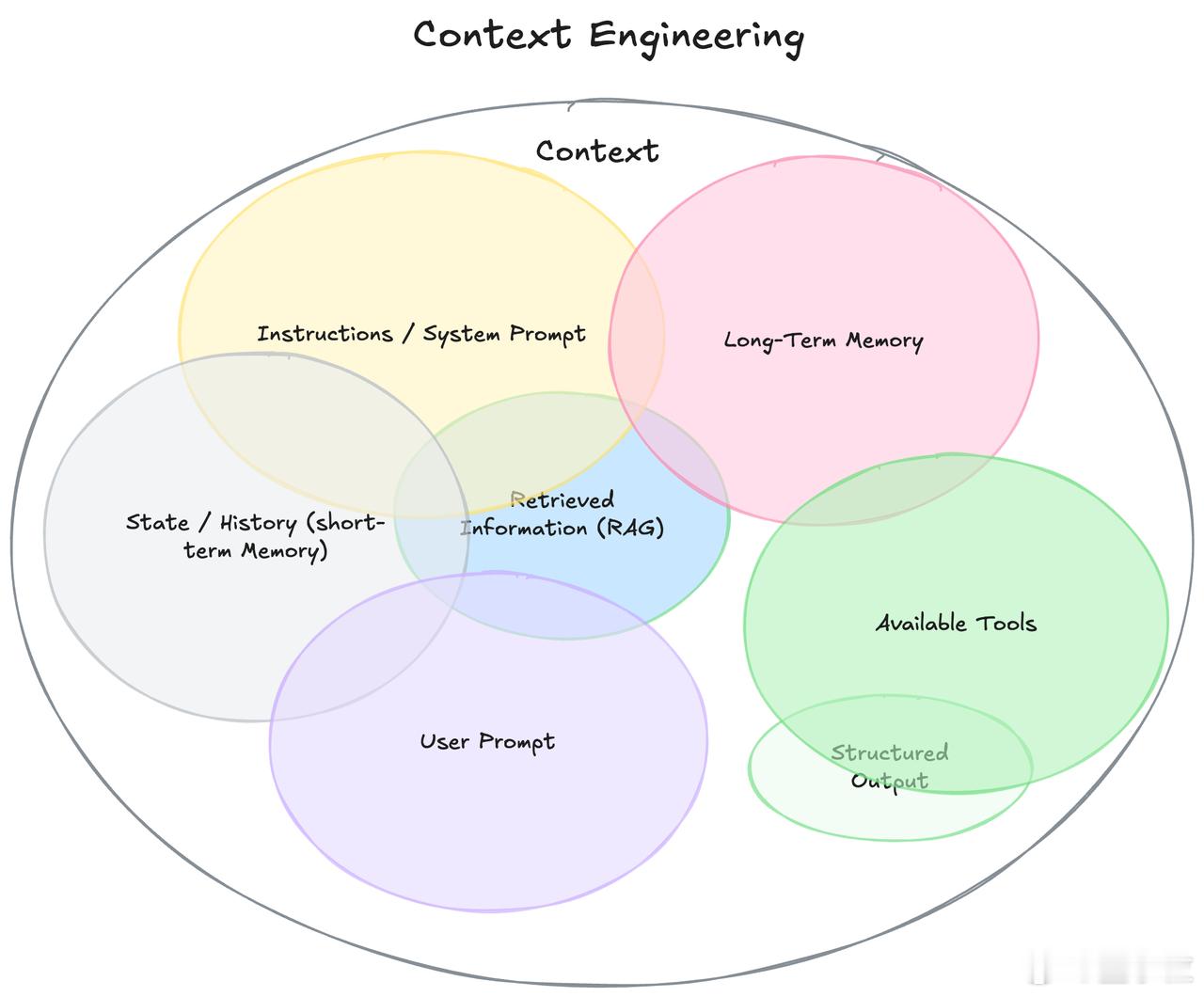

下面来拆一下,什么是“上下文”:

- 系统提示(System Prompt):定义AI的角色、规则和工作方式,相当于开场设定。

- 用户提问(User Prompt):就是你输入的那句话。

- 短期记忆(State/History):当前对话的上下文,之前你说过啥、它说过啥。

- 长期记忆(Long-Term Memory):AI存储下来的信息,比如你常用的语气、之前的项目总结等。

- 外部检索信息(RAG):AI从知识库、网页、数据库等调来的新信息。

- 可用工具(Available Tools):AI可以调用的功能,比如发邮件、查库存。

- 结构化输出(Structured Output):输出要遵循的格式,比如必须返回JSON。

用个例子对比就懂了:

你收到一条Jim的邮件:“明天有空聊一下吗?”

一个“Demo”型Agent看到这句话,只会干巴巴地回:“谢谢你的消息,请问你想几点聊?”

一个“高质量”Agent,会先查你的日历(你明天全满)、找出这个人是合作方、看你俩之前的语气,再调用发会议邀请的工具,最后回:“Jim,明天我排满了,周四上午有空,我发了个邀请,你看下方便吗?”

差别不是模型聪不聪明,而是有没有给它**足够的上下文**。

所以,Context Engineering的核心是:

- 它是一个系统,不是一句话;

- 它是动态构建的,任务不同,信息组合不同;

- 它需要挑选正确的信息和工具,在正确的时间提供给AI;

- 而且还要格式清晰、简洁明了。

从Prompt走向Context,是Agent时代的必然进化。

想让AI真正做成事,不只是调模型,更是设计上下文的能力。

有网友评论道:“这才是未来AI应用的门槛所在。”