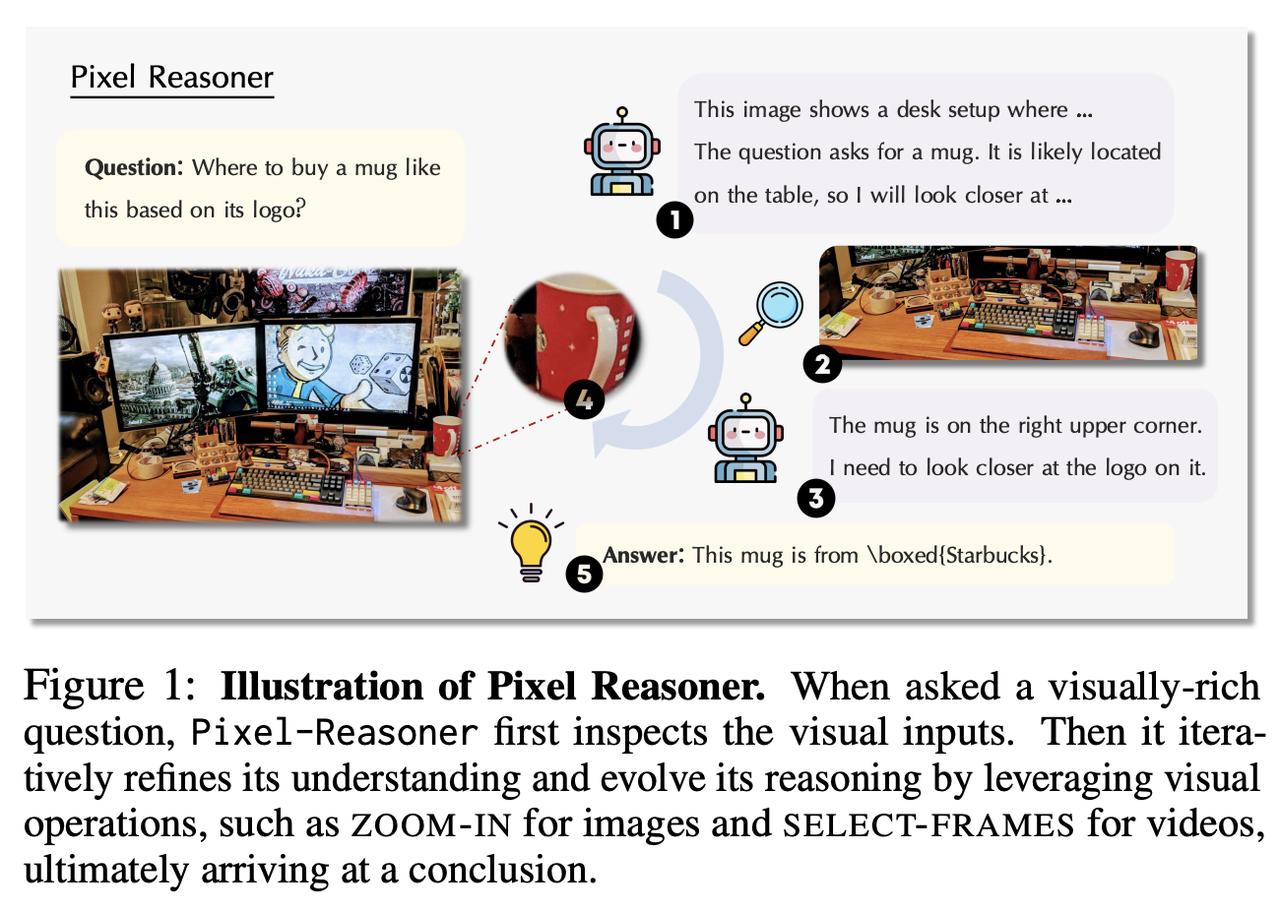

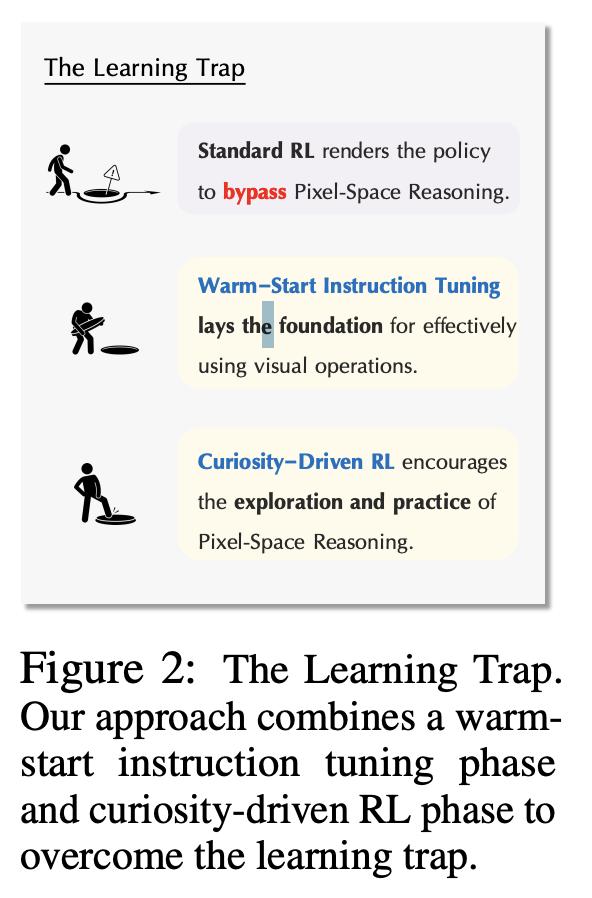

给AI提供一张“要素过多”的书桌照片,它能精准地指出桌面水杯的来历吗?【图1】 目前,多数视觉语言模型主要通过文字来分析图像,这限制了它们对视觉细节的深入理解和直观推理。 受GPT-o3图像内思考的启发,来自港科大和中科大的研究团队推出了开源框架Pixel Reasoner,让模型在像素空间中进行推理。 Pixel Reasoner将视觉操作(如放大、选取)直接转化为AI的推理动作,从而构建出更直接的视觉推理机制。 在训练过程中,研究人员发现视觉语言模型常常存在“偏科”现象:文本推理强而像素空间推理弱。 这导致AI常倾向于放弃视觉操作,转而依赖文本推理,只为追求“正确答案”。 为了解决这个问题,团队采用了两阶段训练:温启动指令调整和好奇心驱动的强化学习。 温启动指令调整 数据收集:从包含丰富视觉信息和明确标注的数据集中,收集视觉语言查询。 专家轨迹合成:利用GPT-4o生成带有视觉操作的专家轨迹,并模拟错误操作以训练AI自我纠正。 训练:通过监督微调(SFT)进行训练,并屏蔽错误操作的损失,防止模型学习执行错误。 好奇心驱动的强化学习: 约束优化问题:将培养像素空间推理的目标形式化为一个约束优化问题,包括像素空间推理的触发率(RaPR)和视觉操作的数量限制。 拉格朗日松弛:通过拉格朗日松弛将约束优化问题转化为无约束问题,引入了“好奇心奖励”和“效率惩罚”。 训练:使用OpenRLHF实现基于GRPO的RL训练,通过选择性样本回放(SSR)解决优势消失问题,让模型在保持效率的同时,更多地利用像素空间推理。 实验表明,Pixel Reasoner在多项视觉推理测试中表现出色,如V* Bench、TallyQA-Complex和InfographicsVQA,超越了现有开源及部分专有模型。 交互式Demo:-Lab/Pixel-Reasoner 项目主页:-ai-lab.github.io/Pixel-Reasoner/ 代码仓库:-AI-Lab/Pixel-Reasoner 论文主页: