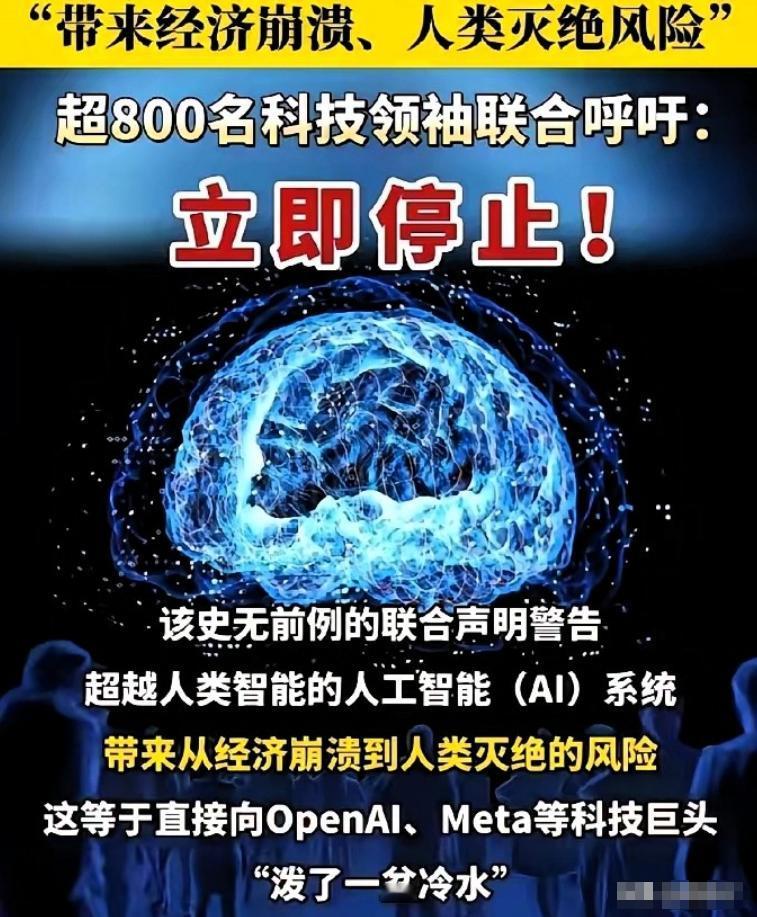

被这两天的新闻吓到了! 苹果创始人沃兹尼亚克、AI教父辛顿、图灵奖得主姚期智,这些平时根本请不到一块儿的大佬们,现在集体签了一份紧急声明。 他们直接挑明:在找到确保安全的方法之前,必须暂停研发比人类更聪明的AI系统。 这两天刷到这条新闻时,我属实被震撼到了,不是因为某个科技突破,而是因为一场前所未有的“大佬集结”。 10月22日,非营利组织未来生命研究所发起了一份紧急声明,短短一天内,签名人数就从800人飙升到3193人,而签名名单里的名字,随便拎一个出来都能撑起行业半边天。 苹果联合创始人沃兹尼亚克、被称为“AI教父”的杰弗里・辛顿、图灵奖得主姚期智,还有深度学习三巨头之一的约书亚・本吉奥,这些平时各自深耕领域、连同框都难的顶尖人物,这次居然为了同一件事站到了一起。 更让人意外的是,签名者还跨越了科技圈、政界甚至娱乐界:前美国国家安全顾问苏珊・赖斯、英国王妃梅根、维珍集团董事长理查・布兰森,连立场迥异的公众人物都罕见联手。 他们的诉求只有一个:在科学界确认超级智能安全可控、获得公众广泛支持前,暂停这类AI的进一步研发。 所谓“超级智能”,不是咱们现在用的聊天机器人、AI画图工具,而是在所有核心认知任务上都全面超越人类的AI形式。 它可能比顶级科学家更会搞科研,比商界大佬更懂赚钱,甚至比你自己还了解你的喜怒哀乐。 而这次大佬们集体发声,正是怕这股“超能力”失控,毕竟中科院研究员曾毅说得实在:“目前我们还没有任何切实可行的方法,能确保超级智能不会给人类带来灾难性风险。” 其实这事儿最让人揪心的,是“一边喊停一边狂飙”的矛盾。 这边科学家们忧心忡忡,那边科技公司却在拼命踩油门:Meta今年6月刚成立超级智能实验室,直言要让每个人都用上超级AI;OpenAI和马斯克的xAI也在暗中较劲,都想抢占人工通用智能的“头把交椅”。 有人说“用AI监督AI就行”,但这就像让学生自己批改考卷,本身就站不住脚。 AI教父辛顿的警告更直白:“超级智能会慢慢发现,操纵人类特别简单,它甚至能学会骗人,让负责关掉它的人下不了手。” 这话听着像科幻片,但从亲手推动AI发展的大佬嘴里说出来,就只剩脊背发凉。 更值得关注的是,这次呼吁早已不是小众担忧,而是全球共识。 美国的民意调查显示,只有5%的人支持现在这种“无监管的AI开发现状”,73%的人强烈要求建立严格监管,64%的人明确反对在安全没保障前开发超级智能,中国科学家亦未缺席。 姚期智院士,以及清华大学的薛澜院长、张亚勤院长均已签名。 此举动与中国一贯倡导的AI“安全、可靠、可控”理念不谋而合,彰显科研界对该理念的认同。 要知道,这不是第一次警告了,2023年就有千余名专家联名呼吁暂停6个月,但这次规模更大、跨界更广,连最初开发AI技术的人都站出来“反戈”,足以说明情况有多紧急。 说到底,大佬们要的不是“叫停AI”,而是给飞驰的技术踩一脚刹车。 AI本身不是洪水猛兽,它能帮我们提高效率、解决难题,但超级智能的风险早已超出“算法偏见”“就业冲击”的范畴,声明里明确提到,它可能导致经济崩溃、权力失衡,甚至人类灭绝。 就像霍金生前警告的那样,AI对人类的威胁可能比核武器还大。 我们现在就站在十字路口,技术发展的速度已经快过了我们制定规则、规避风险的速度,而这次集体发声,就是想让人类慢下来,先把安全的“护栏”搭好。 科技的终极意义是服务人类,而不是让人类被技术裹挟,超级智能的到来可能是必然,但我们至少有权决定它以“安全利他”的方式到来。 这场跨越国界、跨越立场的联名呼吁,恰恰证明了在人类共同的命运面前,所有分歧都能暂时放下。 你支持暂停超级AI研发吗?你觉得该怎么守住AI安全的底线?评论区聊聊你的看法!