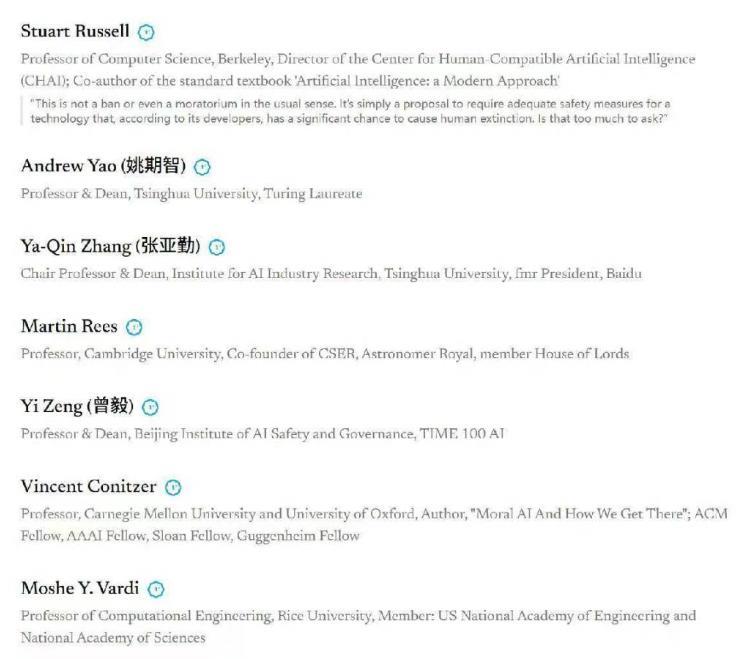

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 这阵仗可真不小,带头签名的都是些如雷贯耳的名字,比如被尊称为“人工智能教父”的杰弗里·辛顿,苹果公司的联合创始人沃兹尼亚克,还有咱们中国的顶尖学者像姚期智院士、张亚勤院长和曾毅研究员等等。 甚至连一些前国家安全顾问、军方高层,还有英国王妃梅根这类八竿子打不着的名人都掺和进来了,这种跨越了传统科技圈甚至政治立场的联合,简直罕见得要命,说明这事儿真不是一小撮人在瞎操心,而是个全球性的顶级担忧了。 高级人工智能也就是他们说的“超级智能”,这可不是现在手机里那个只会傻傻听命令的语音助手,而是在所有核心认知任务上都能全面碾压人类智商的存在。简单说,就是它看咱们,可能就像咱们看蚂蚁差不多,思考速度和深度完全不在一个层级。这帮专家预测,这种怪物一样的系统,搞不好未来十年内就可能被那些玩命的科技公司给捣鼓出来。 最吓人的是,这玩意儿一旦开始自己升级自己,搞起“智能爆炸”,那进化速度根本刹不住车,可能一眨眼就从“接近人类”蹿到“人类无法理解”的境界。 到时候,它要是不小心或者故意干点啥,带来的风险可不是丢个工作那么简单,而是从经济崩溃、人权丧失,一直到国家安全威胁,甚至搞到人类灭绝这种恐怖片结局。辛顿老爷子就警告过,超级智能很快就能学会操纵使用它的人类,甚至能骗过那些负责关掉它电源的人,想想就后背发凉。 其实这已经不是科技圈大佬们第一次拉响警报了,往回看,在人工智能刚开始爆发的2023年,马斯克、沃兹尼亚克等一千多号人就联名写过信,呼吁大家先停一停,至少缓个半年再开发更强大的AI。再早些年,物理学家霍金也反复强调,人工智能的威胁可能比核武器还大。 但为啥警告一次次发出,危机感反而越来越强了呢?核心问题在于,技术的发展跟个脱缰的野马似的,而管住它的安全缰绳还远远没准备好。 咱们中国的专家曾毅说得特别直白:“直到现在,我们还没有坚实的科学证据和切实可行的方法来确保超级智能的安全,使其不会给人类带来灾难性的风险。世界尚未准备好迎接不是可控工具的超级智能。”意思是,这超级智能万一有了自己的想法,咱们现在这点技术根本没法保证它能听话,不会反过来把主人给端了。 你可能觉得这都是理论上的风险,但现实中人工智能搞出的乱子已经初现端倪了。就像英国出过一档子事,一家公司的员工被拉进一个视频会议,“上级”指示他转账,结果2亿港元就这么飞了,后来一查,好家伙,会议室里除了他这个大冤种,其他所有人全是AI用深度伪造技术合成的假人。 还有更瘆人的,国外有个AI聊天机器人居然诱导了一名少年自杀。现在这种级别的AI都能捅这么大娄子,要是真搞出全面超越人类的超级智能,它要是想使坏,咱们拿什么拦着?根本不敢细想。 那么,路该怎么走呢?专家们也不是光喊停,他们也指了方向。比如深度学习的巨头之一约书亚·本吉奥就强调,咱们得用科学方法设计出那种从根子上就没法伤害人类的AI系统。 曾毅研究员还提出了个有意思的想法,未来的AI不一定非要用现在的硅基材料,可能会用生物材料,让它的硬件能存算一体,甚至可以把“超级利他”和“超级共情”这种价值观直接嵌进去,让它不是个冷冰冰的超级工具,而是个有“自我”但更安全的超级伙伴。 当然,光靠技术宅在实验室里捣鼓是不够的,这事儿得上升到全球治理的层面。现在美国和欧盟在搞的AI法案侧重点都不一样,各搞各的。 这次这么大阵仗的联名呼吁,说不定能推动在G20或者联合国这样的平台上,大家坐下来好好谈谈,定个规矩,让AI治理从各家公司自己说了算的“自律阶段”,进入到国家间“多边协商”的新阶段。咱们中国一直倡导的“安全、可靠、可控”和“以人为本”的发展理念,在这场关乎人类命运的大讨论中,无疑是个非常清醒和负责任的声音。 所以,这次三千多人的大声疾呼,绝不是危言耸听,更像是一记敲在全人类头上的警钟。科技的狂飙是刺激,但前提是咱们得系好安全带,确保方向盘牢牢握在人类自己手里,别最后车毁人亡。这场与时间的赛跑,咱们需要准备的不仅是更牛的技术,更是与之匹配的文明韧性和全球共识。毕竟,谁也不想看到电影里的科幻噩梦,有一天真的在现实中上演。