[LG]《An efficient probabilistic hardware architecture for diffusion-like models》A Jelinčič, O Lockwood, A Garlapati, G Verdon... [Extropic Corporation] (2025)

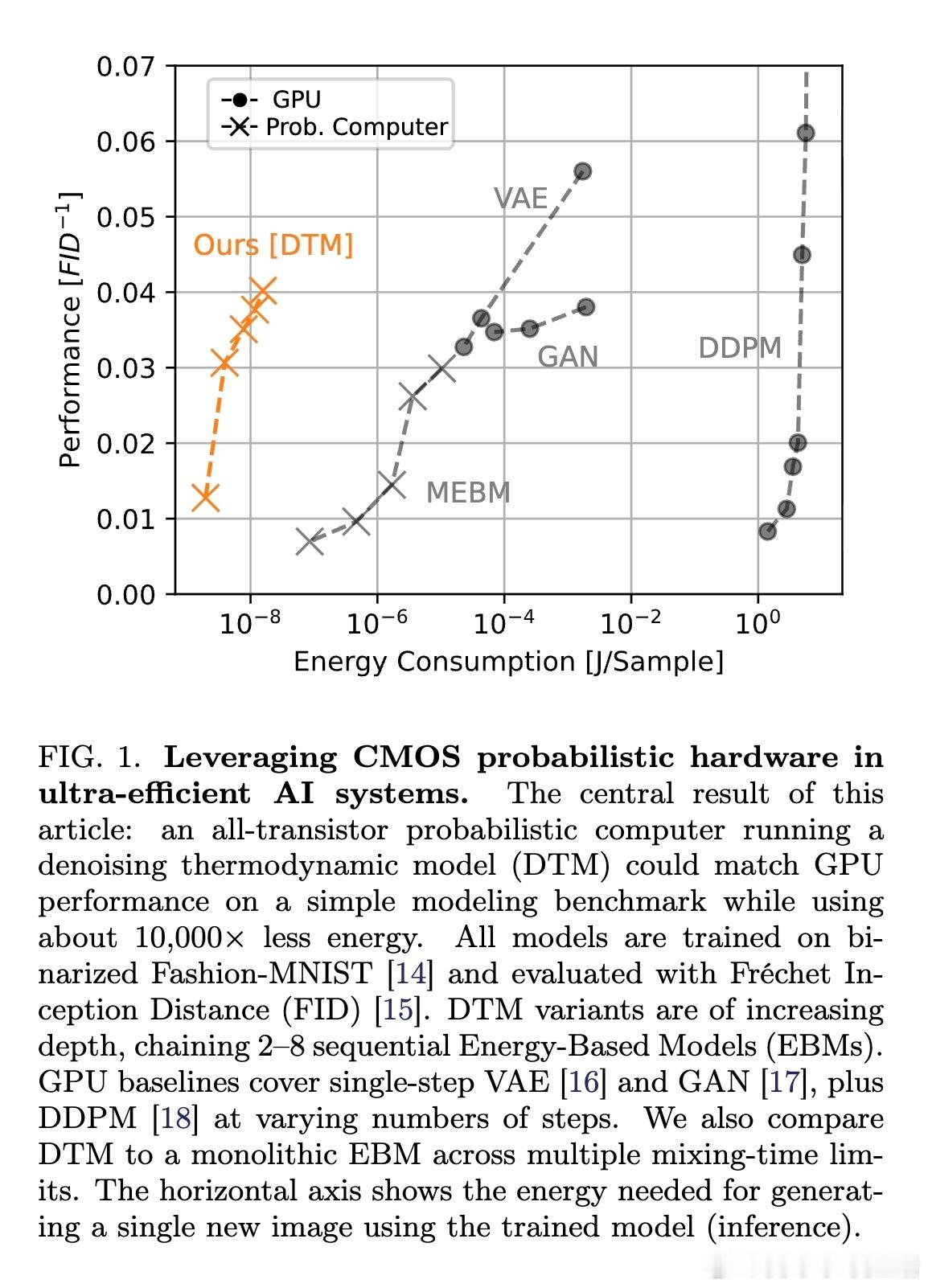

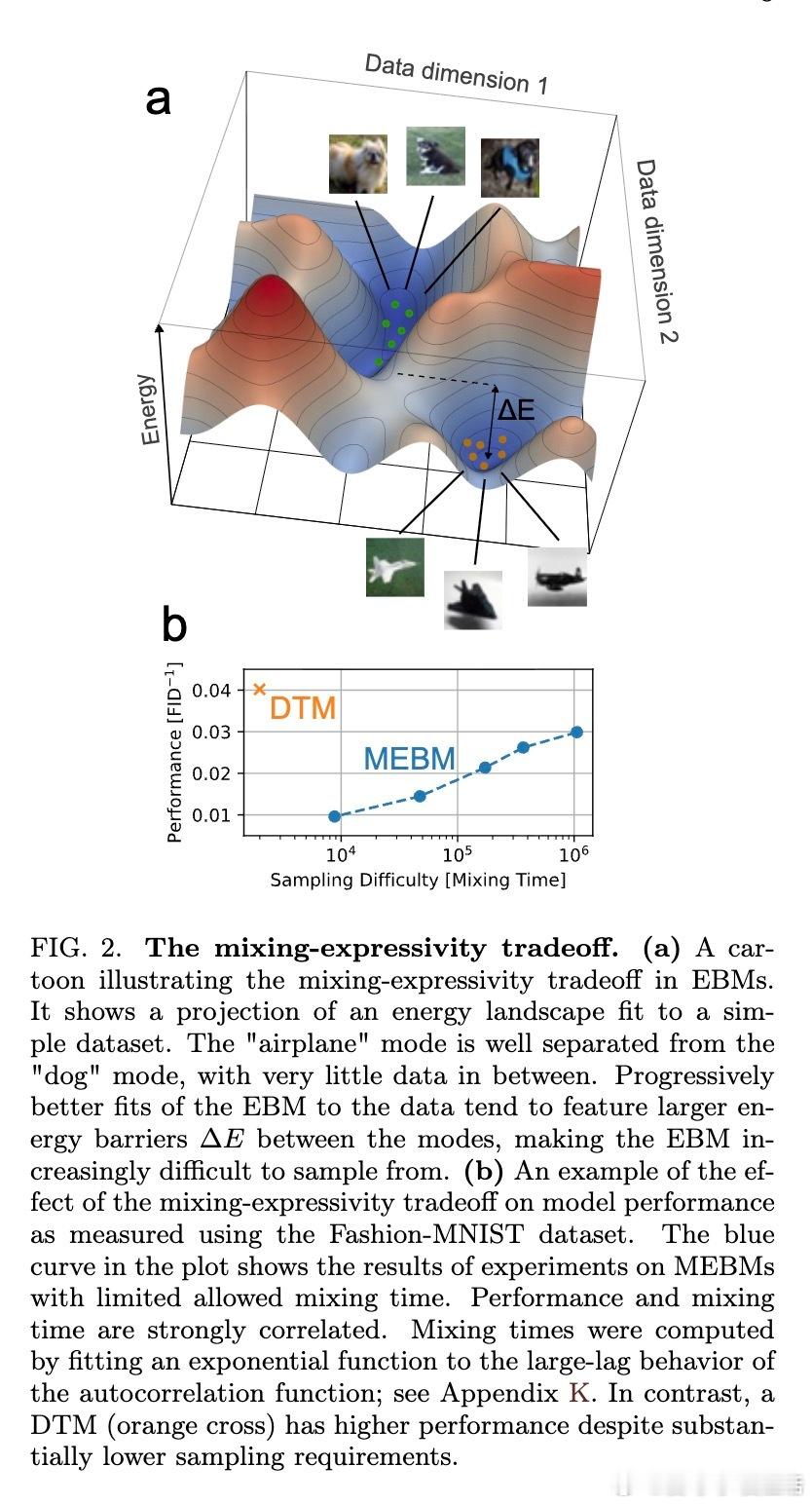

本文提出了一种创新的全晶体管概率计算机架构,针对能量基模型(EBMs)存在的混合时间与表达能力的权衡难题(mixing-expressivity tradeoff,MET)进行了突破。传统基于单体EBM的概率硬件因复杂的能量景观导致采样效率极低,难以扩展。本文通过引入去噪热力学模型(Denoising Thermodynamic Models,DTMs),将复杂的概率分布分解为多个易采样的EBM链,实现逐步去噪过程,从而绕开MET限制。

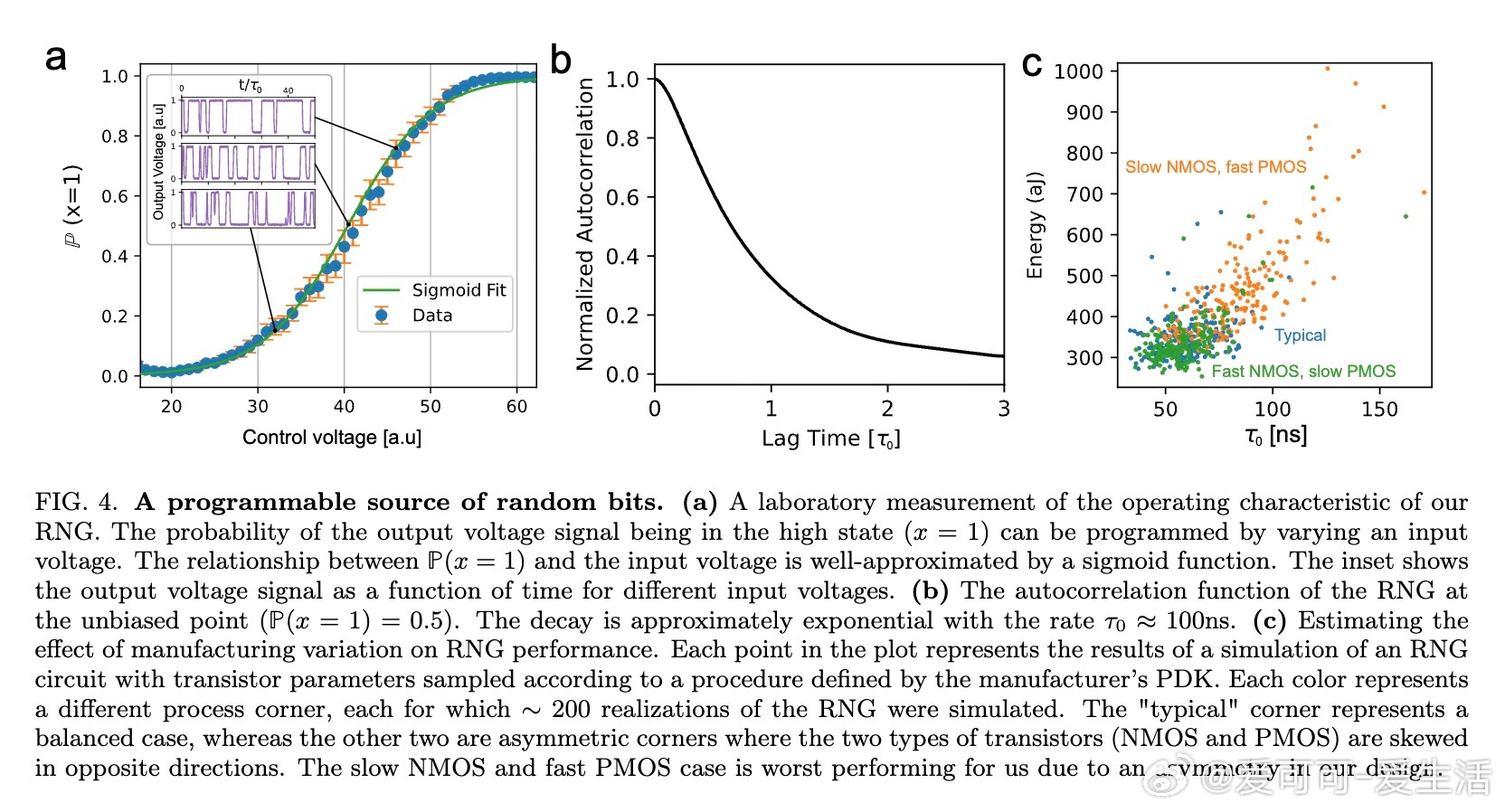

DTM架构利用多个浅层EBM串联建模反向扩散过程,每一步的能量景观较为平滑,采样混合时间显著缩短,训练更稳定。硬件实现方面,作者设计并测试了基于CMOS工艺的全晶体管随机数生成器(RNG),其输出概率可由控制电压调节,具备快速(约10 MHz)、低能耗(约350 aJ/比特)和小面积(约3μm×3μm)等优点,避免了依赖异构随机元件带来的集成难题。

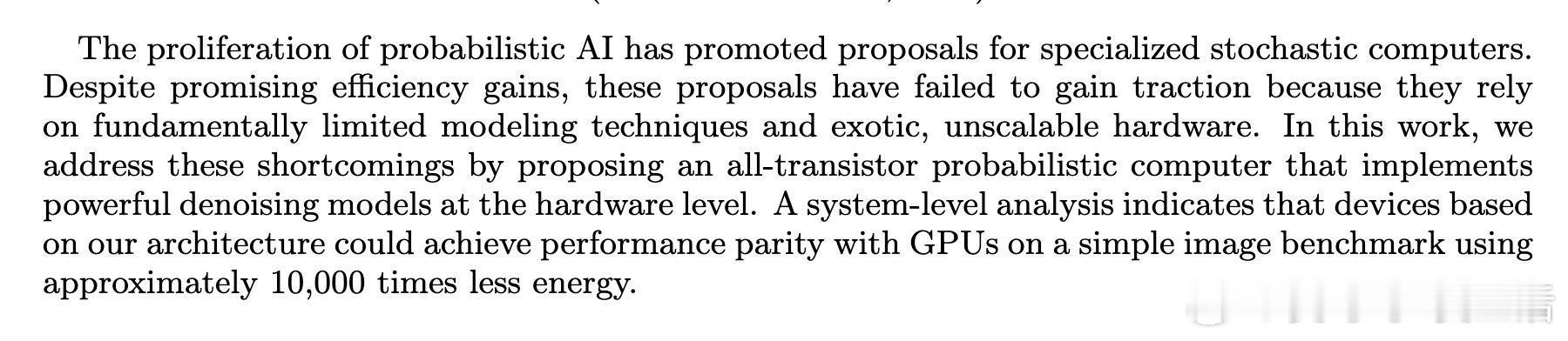

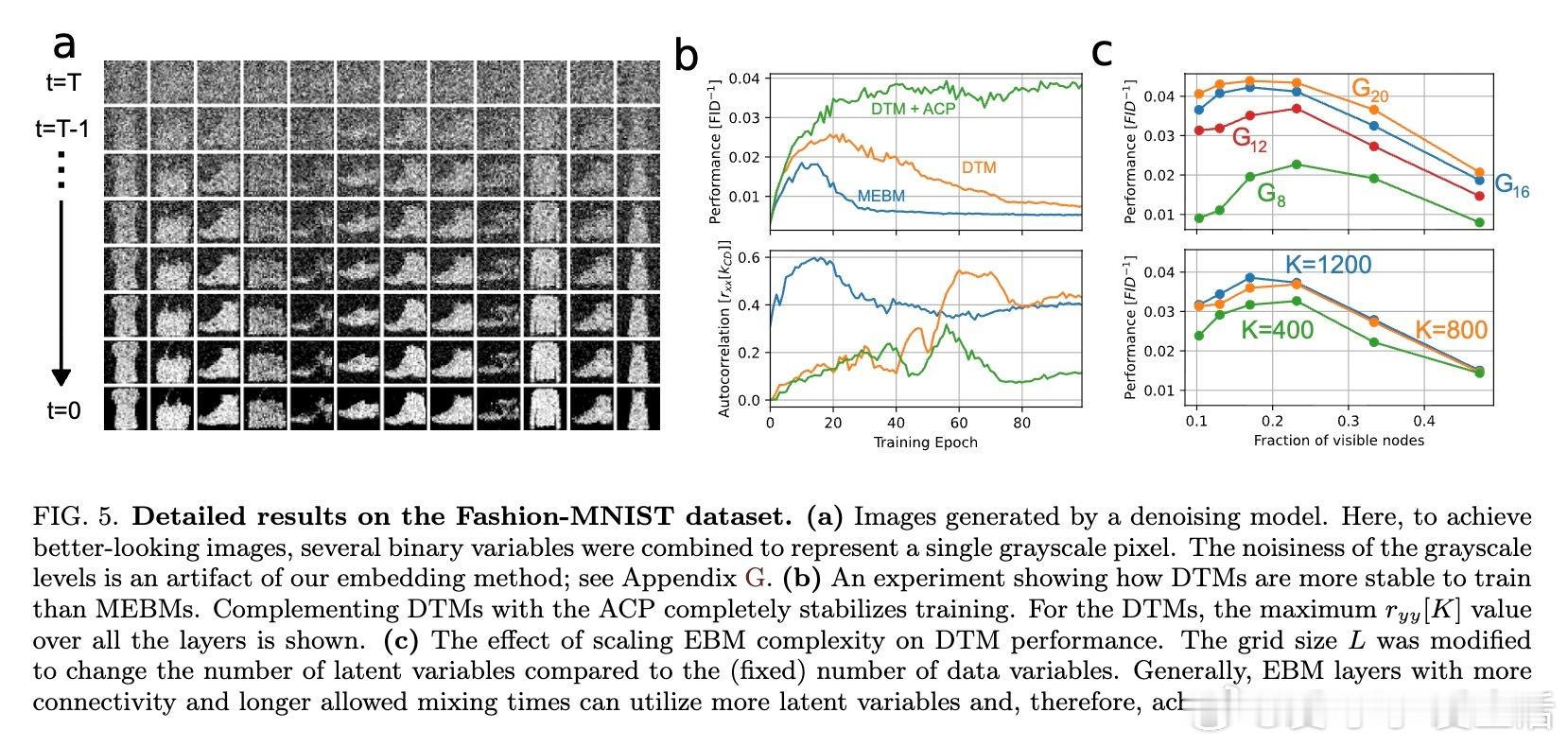

系统级模拟表明,基于DTM的概率计算机在处理Fashion-MNIST图像生成任务时,能耗相比GPU降低约10,000倍,且生成质量达到GPU上扩散模型的同等水平。该架构支持模块化设计,可在单芯片上实现多个EBM层,或跨芯片分布,实现灵活扩展。训练过程中,通过引入自适应总相关惩罚项(Adaptive Correlation Penalty,ACP),有效控制模型采样的混合性,保证采样链接近平稳状态,从而获得高质量梯度估计,提升训练稳定性。

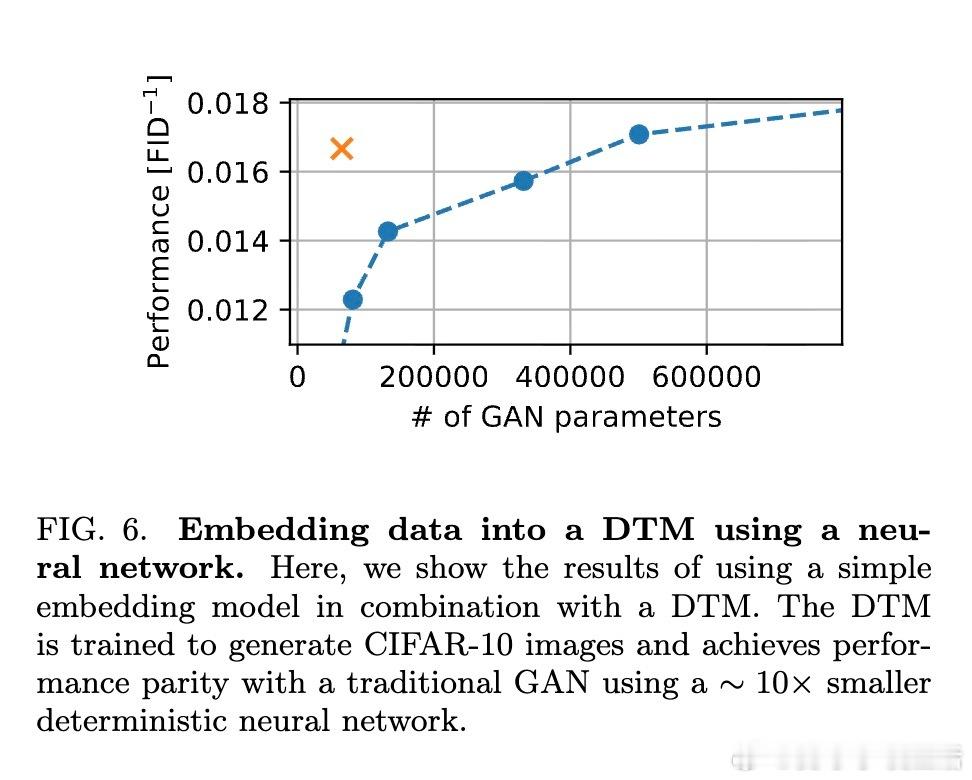

此外,论文指出未来概率计算机应与传统确定性处理器结合,形成混合热力学-确定性机器学习(Hybrid Thermodynamic-Deterministic Machine Learning,HTDML)系统,实现能效与性能的最优平衡。为解决现实数据嵌入问题,初步尝试用小型神经网络将复杂数据映射至DTM的二值空间,构建混合生成模型,初步效果显示可用较小的确定性网络匹配传统GAN性能。

该工作不仅从算法层面创新DTM结构,还从硬件设计实现了可行的高效随机电路,系统分析充分反映了潜在的巨大能效优势。所提出的概率硬件架构为大规模AI系统的能耗瓶颈提供了切实可行的替代方案,开辟了概率计算与扩散模型硬件加速的新方向。

详细内容及开源代码请参考原文: